以硬核基座,托举Agentic AI颠覆创新!re:Invent 2025 Peter&Dave主题演讲回顾!

北京时间12月5日,亚马逊云科技re:Invent 2025倒数第二天,亚马逊云科技公用计算高级副总裁Peter DeSantis和亚马逊云科技计算与机器学习服务副总裁Dave Brown带来了一场十分硬核的主题演讲《基础设施创新》,系统阐述了AI时代云基础设施的核心价值。

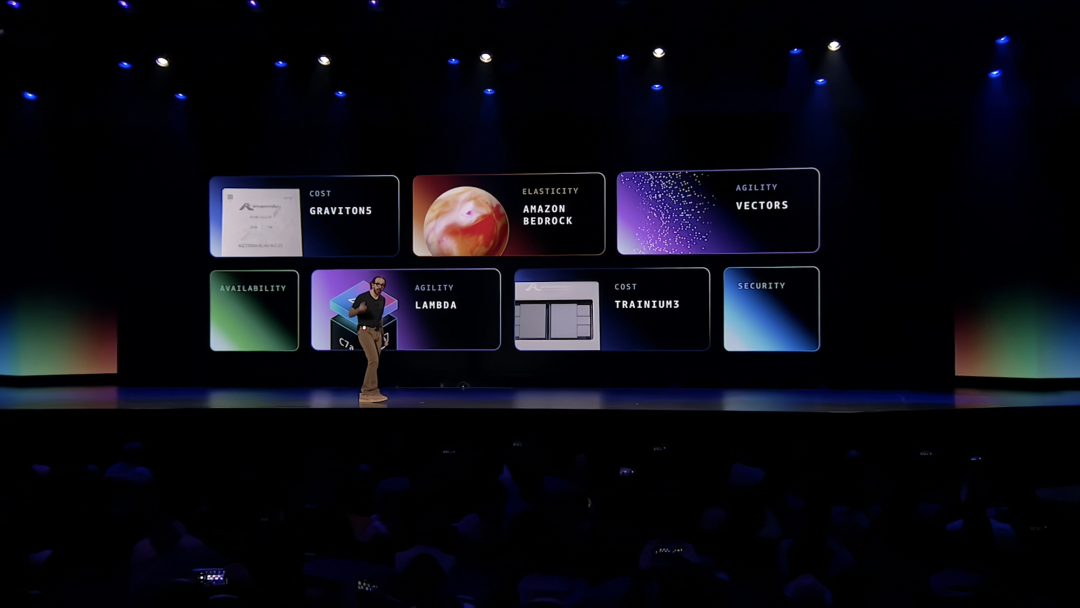

从Amazon Graviton5处理器到Amazon Lambda Managed Instances,从Project Mantle推理引擎到Amazon S3 Vectors向量存储,再到Amazon Trainium3 UltraServers和Amazon Trainium4芯片,一系列重磅发布,完整展示了亚马逊云科技从Amazon Nitro到Amazon Graviton再到Amazon Trainium的自研芯片战略,如何为客户创造无与伦比的性能和成本优势。

AI时代

云计算的“基本功”更加重要

Peter DeSantis开场就抛出一个观点:AI正在改变应用开发方式,但云计算的核心属性不仅不会改变,反而变得更加关键。

安全性:AI让攻击者也更高效,云提供商必须将安全作为首要优先级

可用性:AI应用规模空前,需要经过最严苛工作负载考验的云基础设施

弹性:AI工作负载需求激增,客户期望获得与Amazon S3相同的弹性体验

成本:AI训练和推理成本极高,降低成本成为关键竞争力

敏捷性:AI转型充满不确定性,需要快速启动、优化和调整的能力

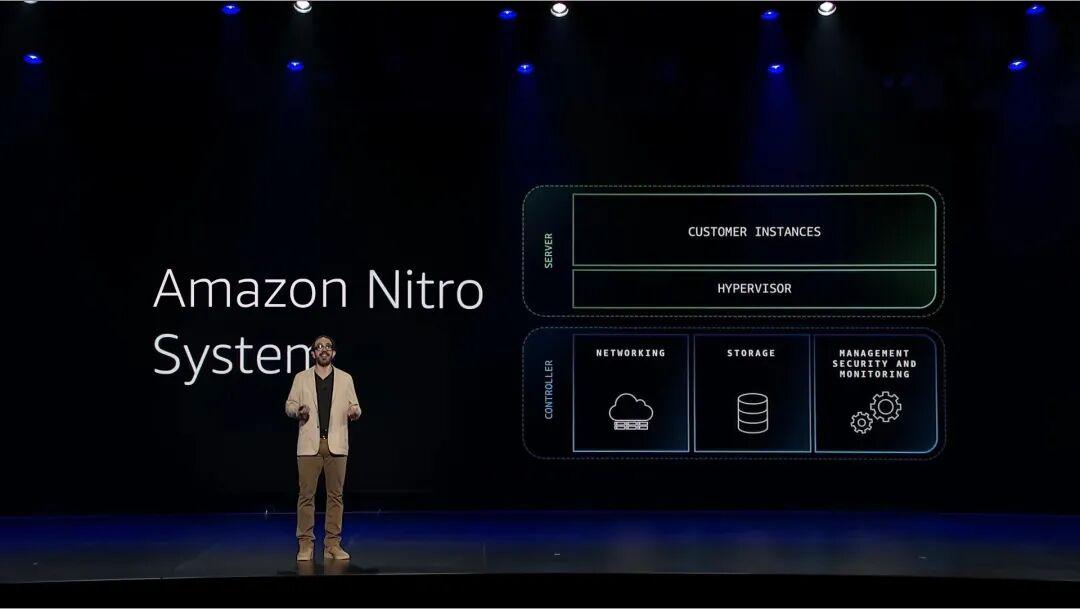

亚马逊云科技的自研芯片战略源于对这些核心属性的深刻理解。Peter DeSantis回顾了2010年Amazon EC2面临的虚拟化性能抖动问题,当时业界普遍认为虚拟化永远无法达到裸金属性能,但亚马逊云科技通过深入优化,最终开发出Amazon Nitro系统,将虚拟化从服务器转移到专用硬件,完全消除了抖动问题,性能甚至超越裸金属。

Amazon Nitro的成功开启了亚马逊云科技的自研芯片之路,证明了控制硅片、硬件和系统架构能够实现商用硬件无法达到的性能和效率提升。这一理念延续到Amazon Graviton服务器处理器和Amazon Trainium AI加速器的开发。值得一提的是,Amazon Nitro系统的技术成就已被纳入计算机科学经典教材《Computer Organization and Design》第7版,成为计算机科学教育的一部分。

Amazon Graviton5

架构突破带来性能飞跃

架构创新与性能飞跃

亚马逊云科技计算与机器学习服务副总裁Dave Brown登台宣布推出Amazon Graviton5处理器,实现了重大架构突破。这款处理器在单一封装中提供192个核心,实现统一快速的内存访问,无需跨CPU互连。L3缓存容量是前代的5倍以上。在散热设计上,Amazon Graviton5移除了传统的保护盖和一层导热材料,采用直接接触硅片的冷却方案,风扇功耗降低33%。基于Amazon Graviton5的M9g实例比M8g性能提升25%,提供Amazon EC2中最佳性价比。

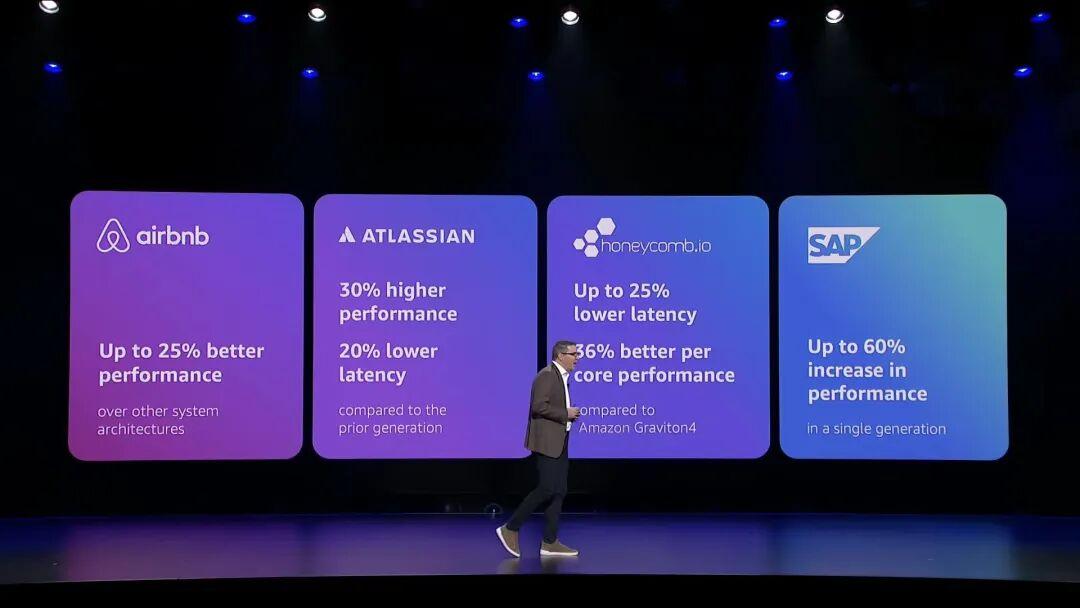

客户验证的真实性能

早期客户已经在生产环境中验证了Amazon Graviton5的卓越性能。Airbnb实现了25%的性能提升,Atlassian延迟降低20%,Honeycomb每核心性能提升36%,SAP HANA OLTP查询性能提升60%。

Apple的Swift on Amazon Graviton实践

Apple云系统与平台副总裁Hiroshi Lockheimer分享了Apple服务在亚马逊云科技上运行的经验。通过将核心服务用Swift重写并迁移到Amazon Graviton,Apple实现了40%的性能提升和30%的成本降低。Swift语言的安全性、现代设计和内置安全特性使其成为服务器端开发的理想选择。Apple已开源Swift,并与亚马逊云科技合作为Amazon Linux提供了首个官方Swift工具链包。

Amazon Lambda Managed Instances

重新定义Serverless计算

重新定义Serverless

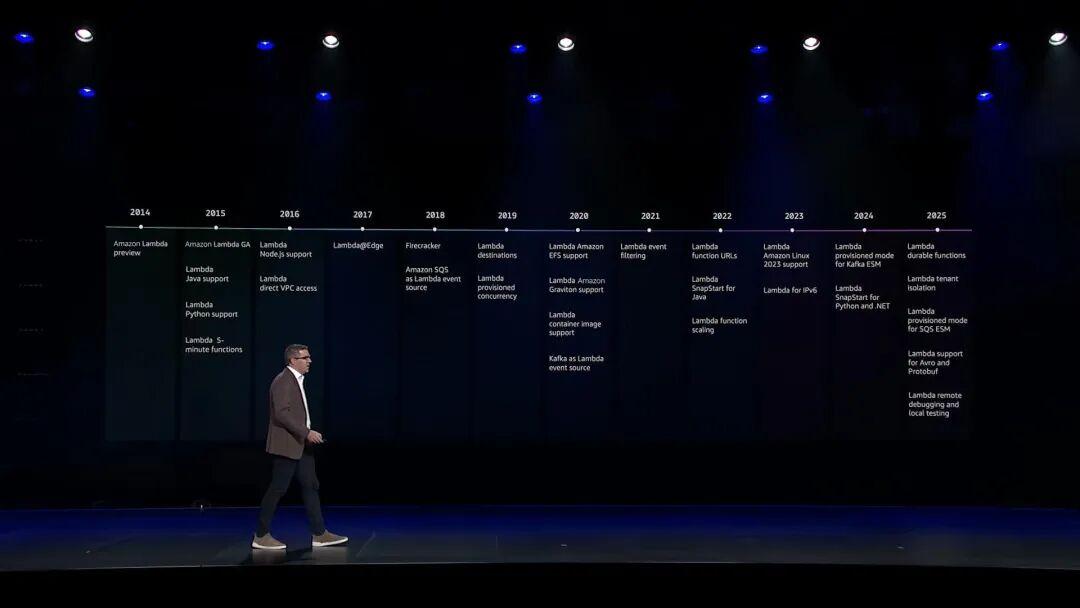

Dave Brown讲述了Amazon Lambda诞生的故事。2013年,一个小团队提出了一个看似不可能的想法:开发者只需提交代码,无需管理服务器。这个想法源于Amazon S3团队处理图片缩略图的需求,最终演变为Amazon Lambda这一革命性服务。Amazon Lambda改变了应用开发模式,让开发者从代码而非服务器开始思考。十年后,Amazon Lambda仍然是从想法到生产的最快路径之一。

Amazon Lambda Managed Instances的突破

这项创新兼具Serverless简洁性与基础设施控制。Amazon Lambda函数运行在客户账户内的Amazon EC2实例上,客户选择实例类型和硬件,Amazon Lambda管理配置、缓存、可用性和扩展。现有Lambda函数无需修改即可使用,客户可同时获得Amazon EC2的性能特性和Amazon Lambda的开发体验,这为视频处理、机器学习预处理、高吞吐量分析等传统上不适合Amazon Lambda的工作负载打开了大门。

正如Dave Brown所说:Serverless的本质从来不是没有服务器,而是没有服务器管理。

Project Mantle为推理工作负载量身定制

推理工作负载的独特挑战

Dave Brown深入分析了推理请求的四阶段流程:分词、预填充、解码、去分词。每个阶段对系统资源的需求完全不同,有的CPU密集、有的GPU计算密集、有的内存带宽密集、有的延迟敏感。在全球规模下,数千客户、数百万请求、数十个模型同时运行,每个请求的资源配置文件在流程中动态变化,这是完全不同的扩展挑战。

Project Mantle的架构创新

亚马逊云科技从零开始设计了Project Mantle推理引擎,现已为Amazon Bedrock的许多模型提供支持。

在服务层级上,系统允许客户将请求分配到三个通道:Priority通道提供实时低延迟,Standard通道提供稳定可预测的性能,Flex通道适合后台任务且效率优先。每个客户拥有独立队列,一个客户的突发情况不会影响其他客户性能。系统使用类似Amazon DynamoDB和Amazon S3的Journal系统持续捕获请求状态,故障时可从中断处恢复而非重新开始。

在调度方面,微调作业成为长时间运行的任务,实时流量激增时暂停,流量下降时恢复,无需单独的训练集群。系统还集成了机密计算保护模型权重和客户数据,提供加密保证。这些创新带来了更一致的延迟、更高的吞吐量、更好的利用率和更强的系统韧性。

向量搜索

连接非结构化数据

Peter DeSantis指出,人脑不仅看到像素,还能理解物理属性、表情和关联。向量让计算机以类似方式工作,将数据点放置在数学空间中,通过相对位置发现有趣的关联。真实的向量编码空间可能有3000个维度,每个维度代表AI嵌入模型从大量数据中学习到的未定义概念。

Amazon Nova多模态嵌入模型

亚马逊云科技推出了业界领先的Amazon Nova多模态嵌入模型,支持文本、文档、图像、视频和音频,将所有这些概念转换为共享向量空间,创建对数据的统一理解。亚马逊云科技将向量能力集成到所有数据服务中,让客户无需学习全新技术栈。

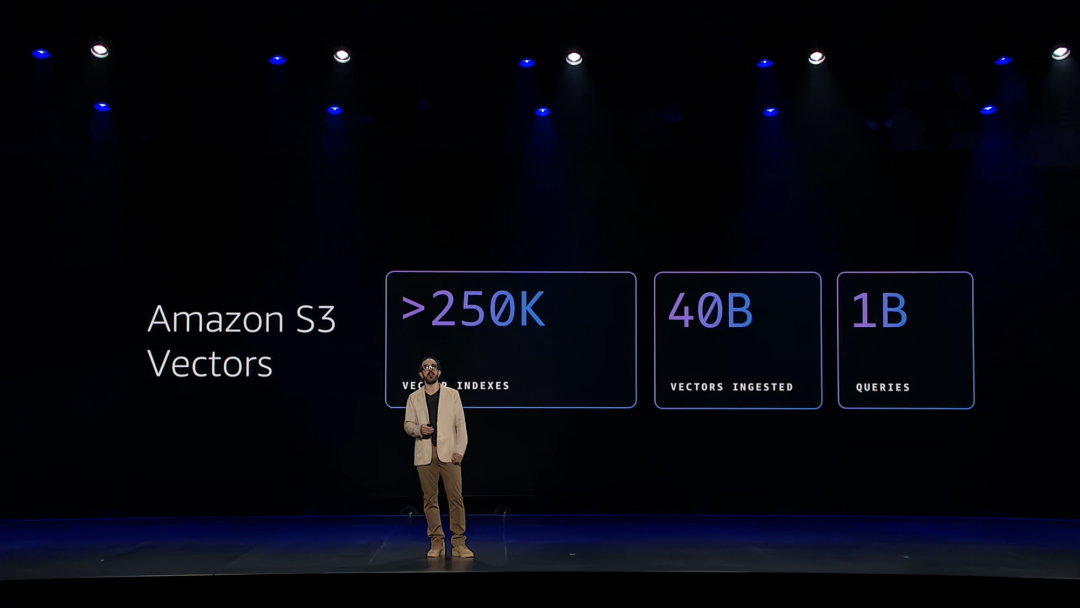

跨服务的向量能力

OpenSearch从精确匹配搜索演进为向量驱动的智能引擎,其混合搜索能力兼具关键词搜索的精确性与语义搜索的深度理解价值。Amazon S3 Vectors将向量存储能力整合至最大的数据服务Amazon S3中,Amazon S3原生成本结构与海量规模为向量数据库提供强力支撑,可实现数十亿级向量的亚100毫秒级查询响应。同时,行业内其他数据库和分析服务也在添加向量搜索能力。

客户案例:Twelve Labs的视频理解

视频AI公司Twelve Labs使用Amazon S3 Vectors为其Marengo和Pegasus基础模型提供支持,高效处理数百万小时视频。Amazon S3 Vectors使他们能够直接在存储源视频的Amazon S3桶中存储数十亿嵌入向量,无需数据迁移或重新架构,显著改善了客户的单位经济效益。Arc XP使用Twelve Labs模型快速分析和丰富档案视频内容,精准发现相关片段以构建新闻故事。

Amazon Trainium

全面突破的AI芯片

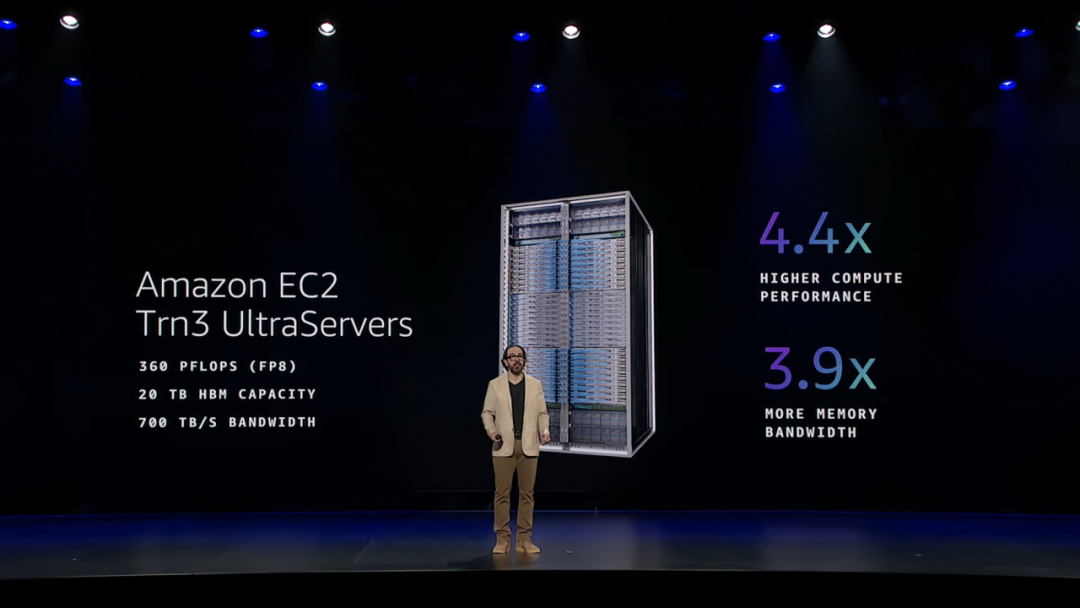

Amazon EC2 Trn3 UltraServers性能全面升级

Peter DeSantis展示了Amazon EC2 Trn3 UltraServers惊人的技术规格:144颗Amazon Trainium3芯片跨两个机架组合成单一AI超级计算机,提供360 petaflops FP8计算能力,比Amazon Trn2 UltraServers高4.4倍。20TB高带宽内存提供700TB/s内存带宽,比上一代高3.9倍。运行GPT-OSS-120B模型时,每兆瓦输出token数是Amazon Trainium2的5倍以上。

系统级创新

Amazon Trainium3服务器展示了多项系统级创新。其首次在同一服务器板上集成Amazon Trainium、Amazon Graviton和Amazon Nitro三种自研芯片。所有组件顶部可维护,支持完全机器人组装,加快部署速度。专用神经元交换机提供全双向带宽和极低延迟。通过Elastic Fabric Adapter实现数千个Amazon Trainium服务器直接内存共享。

芯片架构持续优化

Amazon Trainium3芯片融入多项微架构优化技术,这些优化虽未体现在官方规格表中却能显著提升真实客户工作负载的运行效率,具体涵盖微缩放、更快的Softmax运算、张量解引用、后台转置、流量整形、内存添加写入及内存分散等核心技术。

Amazon Trainium4性能将持续领跑

Peter DeSantis披露Amazon Trainium4正在开发中,承诺提供比Amazon Trainium3高6倍的FP4计算性能、4倍内存带宽和2倍高带宽内存容量。这将确保了亚马逊云科技在AI芯片领域的长期领先地位。

开发工具全面升级

Nki:将于2026年第一季度正式发布,结合矩阵操作简洁性与指令级硬件访问能力,采用全栈开源设计。

Neuron Profiler:利用芯片上的专用硬件进行性能分析,不影响生产代码性能。

Neuron Explorer:提供直观界面展示详细分析数据,自动检测瓶颈并建议优化。

PyTorch原生支持:预计明年初发布,只需将代码从.to("cuda")改为.to("neuron")即可在Amazon Trainium上运行。

客户案例:Anthropic与Descartes AI

Anthropic在Amazon Trainium上训练和运行Claude最新一代模型。Descartes AI使用Amazon Trainium3和Nki优化实时视频生成模型,实现了4倍帧率性能提升和80%的张量核心利用率,远超传统GPU系统。

Descartes AI在re:Invent 2025现场,展示了革命性的“实时视觉智能”技术,能够实时生成每一帧画面并将演讲者无缝转换为动画角色,全程零延迟运行。这项技术将应用于直播体育、游戏、购物和机器人仿真训练。

结语

引领AI时代的基础设施

Peter DeSantis总结道,AI对基础设施的意义是让基础属性比以往任何时候都更重要。从Amazon Nitro到Amazon Graviton到Amazon Trainium的持续投入不仅是为了解决过往的技术痛点,更是为了全力迎接Agentici AI新时代的到来。而今天展示的成果证明了亚马逊云科技在云基础设施领域的卓越地位。

AI仍在破晓之初,未来藏着未知转折与无限变量,新架构将破土而出,新可能将陆续迸发。亚马逊云科技将如过去二十载般始终在场,移除约束,提供构建单元,帮助客户驾驭未来的一切可能。

What will you build next?这不仅是一个问题,更是向所有构建者发出的邀约——在卓越的云基础设施上,创造AI时代的无限可能。

来源:至顶网CIO与CTO频道

好文章,需要你的鼓励

CIOs将AI采纳列为首要任务:调查报告

最新调查显示,近半数CIO将AI采用和自动化提升列为未来五年的首要任务。超过三分之一的受访者将加强业务连续性和灾难恢复作为重点,同等比例的企业将人才技能发展列为优先事项。尽管AI投资成为焦点,但投资回报率仍不明朗,近三分之二的商业领袖估计AI投资回报率仅为50%或更低。

微软亚洲研究院联手清华大学:让AI看图不再“雾里看花“的双向感知新技术

微软亚洲研究院与清华大学联合提出双向感知塑造技术,通过创新的两阶段训练方法解决AI视觉理解中的关键问题。该技术让AI学会正确聚焦重要视觉信息,避免被无关内容误导。仅用1.3万训练样本就在八个基准测试中平均提升8.2%性能,超越使用数十万样本的专门模型,为AI视觉推理能力提升开辟新路径。

红帽收购Chatterbox Labs加强AI治理能力

红帽公司宣布收购伦敦AI公司Chatterbox Labs,该公司专注于模型测试和生成式AI护栏技术。此次收购将为红帽AI产品组合增加自动化AI风险评估、安全测试和治理功能。Chatterbox Labs的AI风险指标帮助企业验证数据和模型是否符合国际法规,提供模型无关的稳健性、公平性和可解释性测试。收购将增强红帽的AI安全能力,包括生成式AI护栏、模型透明度和预测性AI验证等功能。

上海交大团队突破大语言模型实时推理难题:让AI在时间限制内既快又准

上海交通大学研究团队开发了TimeBill框架,解决大语言模型在实时应用中的时间不确定性问题。该系统通过精确预测回答长度和执行时间,动态调整AI记忆管理策略,确保在规定时间内完成任务的同时保持回答质量。实验显示TimeBill在各种时间预算下都能实现最佳的完成率与性能平衡,为AI在自动驾驶、工业控制等安全关键领域的应用提供了重要技术支撑。

以伙伴优势共筑AI Agent新时代!re:Invent 2025 Dr. Ruba Borno演讲精华回顾

靠谱、高效的构建AI Agent实操手册!re:Invent 2025 Swami博士主题演讲划重点!

通往数十亿Agents的未来!re:Invent 2025 Matt Garman主题演讲精华!

Trainium3+Graviton5打出组合拳,Lambda迈入可控时代

Agentic AI军备竞赛升级!亚马逊云科技亮出“底牌”,定义下一条赛道

2025 re:Invent :亚马逊云科技把Agentic AI生态梳理明白了

汇丰PayMe成功迁移至亚马逊云科技 加速推动香港电子支付创新

亚马逊云科技与OpenAI宣布达成多年战略合作

亚马逊云科技的“AI毛坯房”,能解决游戏出海80%需求吗?

亚马逊云科技第三期创业加速器圆满收官 助力初创释放Agentic AI潜力 加速全球化进程