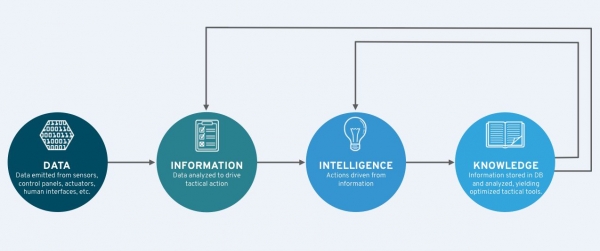

物联网:将数据转化为信息和知识

在今天的信息时代,数据是成功的关键因素。然而,获得正确的数据并能够对其进行分析以获得关键和准确的见解是至关重要的。正如爱因斯坦曾经说过的那样:“并非能考虑到的事物都重要,而所有重要的事物并非都在我们的考虑之内。”

不要将数据与信息混淆。需要对数据——原始的测量集合——进行过滤和评估,以便将其纳入被认为是信息的学习中。旧的陈词滥调“信息超载”确实是错误的——您可以使数据过载,但信息始终是有价值的。数据本身不一定是可用的。如果没有被过滤或评估得当,可能会导致错误的假设,就像我们最近看到的那些假消息一样。

在过去的十年左右,数据量已经增长了数量级。《纽约时报》报道,2005年整个数字宇宙的规模是1300亿千兆字节。今天的企业环境常常处理PB级的数据。随着每天数据源数量的增加,处理会越来越快。要了解有事情如何发生变化,请查看下面的图片,在1956年加载到飞机上的IBM硬盘驱动器。根据@HistoricalPics的推文,这是一个5 MB的硬盘驱动器,称重超过2000磅!与今天的智能手机比一下。

随着我们开始测量移动用户活动和传感器数据,各种数据类型也在增加。需要记住的是,所有这些数据都不意味着什么,除非你把它变成智力,而且将智力转化为行动。

物联网的力量在于其能够实时捕获数据并能够快速合成的能力。当架构正确时,物联网可以帮助将数据转换为确定接下来应采取的行动所需的有用信息。

如《哈佛商业评论》中Kristian J. Hammond所说:“在大多数情况下,我们知道我们想要的数据。我们知道需要运行什么分析,需要找到哪些相关性,需要做什么比较。通过将我们所知道的并将其置于自动化系统的手中,可以进行所有这些操作,然后以人为本或自然语言将其解释给我们,我们可以从始终保持的数据实现洞察力的有效性和规模它的承诺,但到目前为止还没有交付。通过拥抱机器的力量,我们可以自动从数据中生成故事,弥补数字和知识之间的差距。”

我们如何将传感变得有意义?

在物联网出现之前,分析各种设备提供的数据的种类和数量是非常困难的。物联网技术提供了将机器数据拉入数据池进行分析的自动化机制,目的是在数据和应用程序管理中采取下一个逻辑步骤。物联网不仅收集和分析数据,而且还自动改进流程。

在介绍过程中的步骤之前,我应该花点时间来定义在谈论物联网环境中数据传输时经常使用的几个术语。北行和南行。北行数据是指从设备,通过网关到云端的数据。它通常是遥测数据,但它可以是命令和控制请求。南行数据从云到网关,或从云,通过网关到设备。南向数据往往也可以是命令和控制信息,如软件更新和请求或更改配置参数。

以下是使用北行和南行通信渠道从传感到意义的方式:

步骤1:传感器提供北行遥测数据。根据架构,该数据可以被预处理并发送到位于传感器附近的现场的数据存储器;例如网关。

步骤2:在网关上的这个临时点对数据进行一定量的分析。在这里,您可以处理数据,例如,总结或转换数据,以准备在数据中心或云中进行更深入的分析。然后,在战术分析中将在网关上处理的信息与先前识别的模式进行比较。这基本上与历史信息的相关性相匹配。根据您发现的模式,可以采取某些措施。但是你也会寻找你不知道的东西,试图发现其他的相关性和推论。例如,您可能不知道当天气低于10度以下,流感药物处方增加了30%时,鸡汤和面巾纸的销售在未来10天内上涨。你可能以前没有注意到。现在,这是一个新的结论,可用于做出业务决策。

步骤3:使用提供的新见解,创建一个可执行的规则。例如,当传感器表示温度已经降到10度以下时,您就可以将仓库里的鸡汤和盒子的纸巾移到靠近货运码头的地方。通过这种方式,您将一个推理变为一个行为——可以被监控、管理和执行的业务规则。

步骤4:在最后一步中,您将该规则编入准则并将其部署到该领域中。在下面显示的信息生命周期图中,您可以看到这是一个迭代过程。

开源如何辅助

开源软件项目提供标准化的工具包,让您可以处理数据并依此实施行动,如Camel和Drools。 Apache Camel是基于Java规则的路由和中介引擎,具有可用于处理数据的企业集成模式。它通过开箱即用的消息中介、路由和数据转换来协助开发者的物联网解决方案。在我看来,在物联网环境中使用Apache Camel的最好方法是通过Eclipse物联网工作组项目,例如Eclipse Kapua和Kura。

来自JBoss社区的Drools,是一个业务规则管理系统,它已经建立了规则模板,允许您定义在某些情况发生时需要采取的行动。Drools对于具有明确定义的DSL(域专用语言)的物联网实现需要定义规则和优化规则引擎所需的可扩展性。它还配有一个名为Workbench的GUI,可以让开发人员轻松创建和编辑规则。

能够将数据转换成可以为您效劳的信息,这是任何物联网工作的核心。而且,正如我之前的博客中指出的那样,通过开源软件可以做到这一点,这将有助于加速物联网的采用和物联网实施的成功。

好文章,需要你的鼓励

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

谷歌宣布对Gmail进行重大升级,全面集成Gemini AI功能,将其转变为"个人主动式收件箱助手"。新功能包括AI收件箱视图,可按优先级自动分组邮件;"帮我快速了解"功能提供邮件活动摘要;扩展"帮我写邮件"工具至所有用户;支持复杂问题查询如"我的航班何时降落"。部分功能免费提供,高级功能需付费订阅。谷歌强调用户数据安全,邮件内容不会用于训练公共AI模型。

AWS推出AI图像编辑新突破:用说话就能精准移动图片中的物体!

这项由香港中文大学和AWS团队联合开发的研究推出了TALK2MOVE系统,实现了用自然语言精准操作图片中物体的位置、角度和大小。该系统采用强化学习训练方式,通过空间感知奖励机制和智能步骤采样技术,在移动、旋转、缩放三类操作上的准确率显著超越现有方法,同时大幅降低了对昂贵训练数据的依赖,为AI图像编辑领域带来重要突破。

研究发现商业AI模型可完整还原《哈利·波特》原著内容

研究人员对Claude、GPT-4、Gemini和Grok等商用AI模型进行测试,发现这些模型能够记忆并完整输出受版权保护的内容。其中越狱后的Claude 3.7 Sonnet能输出95.8%的《哈利波特与魔法石》内容,而Gemini和Grok在无需越狱情况下也能输出超过70%的内容。这一发现可能对正在进行的AI版权诉讼产生重要影响,目前多家AI公司面临超过60项相关法律诉讼。

斯坦福大学等联合发布:AI助手在企业政策执行上竟然“偏科“得如此严重

斯坦福大学等知名机构联合研究发现,企业AI助手在执行组织政策时存在严重"偏科"问题:处理允许请求时成功率超95%,但拒绝违规请求时仅13-40%。研究团队开发的COMPASS评估框架通过8个行业5920个测试问题,揭示了AI助手普遍缺乏"拒绝技能"的问题,并提出了针对性训练解决方案。

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

研究发现商业AI模型可完整还原《哈利·波特》原著内容

Razer在2026年CES展会推出全息AI伴侣项目

CES 2026:英伟达新架构亮相,AMD发布新芯片,Razer推出AI奇异产品

通过舞蹈认识LimX Dynamics的人形机器人Oli

谷歌为Gmail搜索引入AI概览功能并推出实验性AI智能收件箱

DuRoBo Krono:搭载AI助手的智能手机尺寸电子阅读器

OpenAI推出ChatGPT Health医疗问答功能

Anthropic寻求3500亿美元估值融资100亿美元

OpenAI收购高管教练AI工具Convogo团队

抛弃传统的市场推广手册,迎接AI时代的新策略

谷歌将Gemini AI功能推送至Gmail,用户可选择关闭