Gartner下调了今明两年云计算支出预测

云基础设施市场现在已经非常庞大,很难再有大的变化。但是,因为人们可以轻松地关闭服务器、存储和网络——就像开启它们那样,预测全球云基础设施开支可能非常困难。

不过,这正是大型IT市场研究机构能够得到高额报酬的原因,Gartner的预测专家刚刚发布了2024年和2025年的云基础设施支出预测,前者已经接近尾声,而后者将在几周后开始——我们所有人欢欣鼓舞之后正在翘首以待。

关于Gartner正在进行的云预测,有趣的是其研究人员不断将更高级别的云服务从预测中剥离出来,至少在其向公众展示的数据集中是这样。去年,Gartner将云管理和安全服务从数据集中剔除,该服务预计将在2024年带来500亿美元的收入。而这次在12月的预测中,Gartner又将云业务流程即服务(BPaaS)从数据集中剔除,预计该服务将带来823亿美元的收入。这两个类别并没有并入其他“即服务”类别,如平台即服务(PaaS)或软件即服务(SaaS)软件服务——与数百亿美元相比,这些类别的变化只是小巫见大巫。Gartner不再这样谈论这两个类别了。

在最新的云计算支出预测中,Gartner表示,原始基础设施即服务(IaaS)计算、存储和网络容量的支出将低于春季时的预期。今年5月,Gartner预计2024年全球IaaS收入将略高于1800亿美元,而现在的预测是1698亿美元。这仍然是21.3%的增长,所以不要为云建设者感到难过。我们认为,人工智能服务器在这一增长中占了很大比重——坦率地说,如果2022年至2024年间近700亿美元的IaaS增量支出中有很大一部分来自人工智能服务器,我们也不会感到惊讶。Gartner 没有对此进行详细说明,我们认为这是因为它想向你推销他们的研究报告。

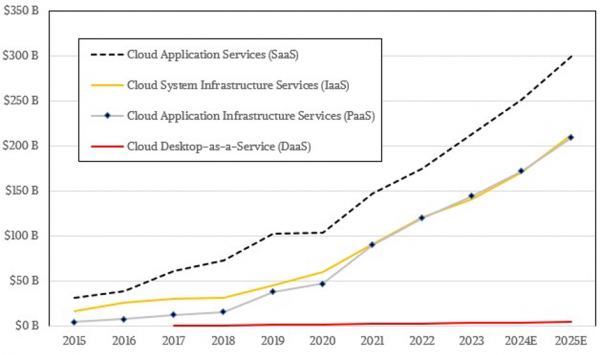

自2021年以来,PaaS的收入或多或少地与IaaS保持一致,并处于相同的支出水平,这是一件值得观察的事情。早在2015年,这是我们从Gartner数据集中获得的最早数据,IaaS 在全球的支出就达到了162亿美元,是PaaS支出38亿美元的4.3倍。四年后,PaaS支出以更快的速度增长,两者在2019年和2020年几乎持平,到了2021年,由于新冠疫情,世界发生了变化,两者开始并驾齐驱。

自2015年Gartner模型推出以来,云销售额的最大部分一直是SaaS,预计将带来全球2508亿美元的销售额。占云计算蛋糕的份额已稳定在40%左右,但十年前这一比例曾超过60%。

桌面即服务(DaaS)尚未起飞,增长速度不快,在云支出的四个类别里占比很小,而且我们认为它作为一个话题即将消失。让我们的个人电脑在云中运行,并通过对功耗要求不高的廉价客户端电脑进行访问,与让我们的个人电脑在本地运行,并配备强大的CPU和GPU以及大型主存储器和闪存,在逻辑上是一样合理的。

但是,我们中很少有人希望在云中运行虚拟PC,我们希望能够在本地使用真正的计算能力完成实际工作——即使将一个带有漂亮图案的笨重冲浪板作为我们的主客户端可能更好、更便宜或更方便。DaaS一直是个哑弹,唯一可能改变这种状况的是企业强制要求使用云PC。我们认为不会出现这种情况。

加在一起,云服务支出(定义为 IaaS + PaaS + SaaS + DaaS)将达到5957亿美元,增长19.2%。

展望2025年,Gartner预计IaaS支出将增长 24.8%,达到2119亿美元;PaaS支出将增长21.6%,达到2086亿美元;SaaS支出将增长21.6%,达到2991亿美元。再加上38.5亿美元的DaaS支出,2025年的云服务总支出将达到7234 亿美元,增长21.4%。

顺便提一下,我们假定在这个数据集中,Gartner没有少算IaaS和PaaS服务,并且从PaaS收入中区分了所有底层 IaaS,从SaaS 收入中区分了所有底层IaaS和PaaS。只有在底层成本被捆绑到云销售的高级服务价格中的情况下,这样做才有意义。

Gartner已经开始跟踪IaaS和PaaS服务捆绑购买时的支出情况,并将其称为云基础设施和平台服务(CIPS)。根据Gartner的数据,2022年,CIPS占IaaS和PaaS总收入的70%,这是一个有趣的统计数字,这一比例在2024年将达到71%,2025年将达到71.6%。

超过三分之二的原始基础设施和平台服务是一起销售的,而且这个比例即将达到四分之三,从长远来看,这就是“云”的含义。如果你选择了一个云,你不仅要选择它对服务器、存储和网络的偏好,还要选择它的平台。我们一直在说,AWS、微软Azure、谷歌云、阿里巴巴云、腾讯云和甲骨文云本身就是完整的平台,与过去或现在的IBM大型机和小型机、Sun Microsystems和惠普RISC/Unix机器或Wintel和Lintel X86服务器一样,都是平台。

好文章,需要你的鼓励

无需Linux即可运行自由开源软件

本文介绍了如何在Windows和macOS等主流操作系统上使用免费开源软件,无需更换操作系统即可摆脱付费订阅。文章推荐了Ninite等工具来安装免费软件,并详细介绍了Firefox、Thunderbird、LibreOffice、VLC等优秀的开源替代方案。作者强调虽然学习新工具需要时间投入,但从长远来看,使用不依赖订阅模式的替代工具将带来巨大回报。

多伦多大学发现:聊天机器人的“嘴巴“影响它们的智商

这项由多伦多大学领导的研究首次系统性地揭示了分词器选择对语言模型性能的重大影响。通过训练14个仅在分词器上有差异的相同模型,并使用包含5000个现实场景测试样本的基准测试,研究发现分词器的算法设计比词汇表大小更重要,字符级处理虽然效率较低但稳定性更强,而Unicode格式化是所有分词器的普遍弱点。这一发现将推动AI系统基础组件的优化发展。

超越 SEO:AI 引擎优化如何改变在线可见性格局

随着生成式人工智能系统提供直接答案而非链接列表,传统搜索引擎优化正面临重大变革。谷歌AI概述功能已覆盖约30%的美国搜索,导致网站点击率大幅下降。专家预测,到2030年AI将占B2B软件研究的70%以上。AI引擎更重视结构化数据、实体识别和权威性,而非传统的关键词和反向链接。营销人员需要采用实体权威工程等新策略来优化AI可见性。

北大研究团队颠覆视频AI训练新方法:让机器像人类一样“预测下一帧“学习世界

北京大学研究团队提出NExT-Vid方法,首次将自回归下一帧预测引入视频AI预训练。通过创新的上下文隔离设计和流匹配解码器,让机器像人类一样预测视频下一帧来学习理解视频内容。该方法在四个标准数据集上全面超越现有生成式预训练方法,为视频推荐、智能监控、医疗诊断等应用提供了新的技术基础。

LangChain核心库曝出严重漏洞,AI智能体机密信息面临泄露风险

Mill如何与亚马逊和全食超市达成合作协议

TechCrunch创业大赛中的9家顶尖生物技术初创公司

2025年印度科技领域十大重要发展

中科大发布Live Avatar:AI数字人无限聊天不翻车

从软件定义汽车到AI驱动质控:Testin云测助力车机测试数智化价值落地

无需Linux即可运行自由开源软件

超越 SEO:AI 引擎优化如何改变在线可见性格局

新Mac必装应用:五款提升工作效率的神器推荐

DXC蒲公英计划:为神经多样性IT专业人士赋能

AMD Strix Halo与Nvidia DGX Spark:哪款AI工作站更胜一筹?

类人机器人投资热潮涌现但商业化仍需数十年

GPU 云服务运营商 CoreWeave 申请上市

IBM 完成 64 亿美元收购 HashiCorp 交易,监管审批已获通过

AI 优化公有云服务商 Together AI 完成 3.05 亿美元融资

Gartner:IT预算下降与AI崛起,CIO要成为“数字先锋”

Azure Files 磁盘存储引入类似 SSD 的预配置计费模式

Kelsey Hightower 谈 AI 热潮回避及 IT 术语词汇表的必要性

Gartner:中国企业弥合基础设施和运营内部云技能差距的三大举措

Gartner发布2025年及未来中国企业实现AI价值的重要预测

Informatica 因收入未达预期股价暴跌 33%,称存在"内部问题"但强调基本面依然稳健

Amazon 在新加坡开设亚太总部