大模型应用开发,CPU如何发光发热?

据英特尔技术专家透露,“英特尔已经基于火山引擎第四代计算实例g4il进行了一系列测试,我们现在已经能够做到在一个云实例里,仅使用CPU就可以运行14B的大模型,这个门槛最低可以降到16vCPU或32vCPU,16vCPU在火山引擎官网的定价仅约3.8元/小时。”

2024 AI服务器市场竞争格局

AI服务器产业链上游为零部件,包括CPU、GPU、存储芯片、固态硬盘、PCB、被动元器件等;中游为AI服务器;下游为各类应用市场,包括互联网企业、云计算企业、数据中心服务商、政府部门、金融机构、医疗领域、电信运营商等。

微软率先拿下HBM驱动的AMD CPU供货

随着“Granite Rapids”至强6的发布,英特尔决定放弃使用HBM内存,转而采用其希望推向主流的MCR DDR5主内存。

AI服务器核心部件产业链剖析(2024)

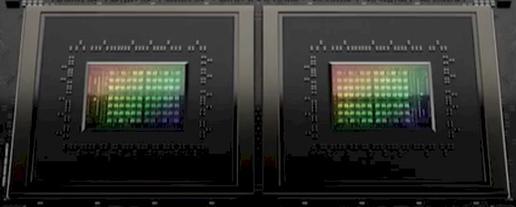

Al芯片是AI服务器算力的核心,专门用于处理人工智能应用中的大量计算任务,Al芯片按架构可分为GPU、FPGA、ASIC和NPU等。HBM作为内存产品的一种,已经成为高端GPU标配,可以理解为与CPU或SoC对应的内存层级,将原本在PCB板上的DDR和GPU芯片同时集成到SiP封装中,使内存更加靠近GPU,使用HBM可以将DRAM和处理器(CPU,GPU以及其他ASIC)之间的通信带宽大大提升,从而缓解这些处理器的内存墙问题。

≈推出“Turin”服务器CPU,再催内力欲扭转局面

如果大家正在考虑升级自己的x86服务器机群——目前确实有不少企业、超大规模基础设施运营商和云服务商都在持币参与讨论——那么好消息是,英特尔和AMD均已推出其有史以来最强大的串行计算引擎。

AMD这场AI浓度爆表的发布:各“U”上阵、性能硬核对标,但掌舵10年的苏妈说:“一切刚开始”

在当下的AI竞争格局下,没什么能比一场AI浓度爆表的大会,更能快速彰显自身实力了,AMD的这场「Advancing AI大会」,就是印证。

从AIDC到AI PC,英特尔如何为AI原生提供算力新答案?

正如近期由英特尔和至顶科技组织的 AI Summit·PEC AI新势力专场活动上,来自产学研的参会嘉宾所达成的一致共识是,智能场景无处不在,来自“端、边、云”的智能算力也无处不在。

从AIDC到AIPC,英特尔如何为AI原生提供算力新答案?

正如近期由英特尔和至顶科技组织的 AI Summit·PEC AI新势力专场活动上,来自产学研的参会嘉宾所达成的一致共识是,智能场景无处不在,来自“端、边、云”的智能算力也无处不在。

聊聊AMD混合CPU-GPU INSTINCT MI300A研发故事:一条漫长而曲折的道路

虽然这笔钱并不算多,但足够让AMD的工程师们有机会考虑整个美国的未来,并为如今强大的CPU与GPU业务埋下种子。

Arm技术媒体分享日:探索AI时代的计算前沿与生态布局

在6月13-14日的Arm技术媒体分享日上,多位Arm技术专家聚首一堂,分享了Arm在终端计算子系统(CSS)、CPU、GPU技术以及软件生态的最新进展与战略规划。

面对服务器CPU之争,英特尔决定将产品线一分为二

面对现实挑战,英特尔决定将其产品线一分为二:其一为传统至强核心(即所谓性能P核),其二为经过改进的Atom核心(即所谓能效E核)。

AMD发布“TURIN”EPYC CPU预览,并扩展INSTINCT GPU技术路线图

苏姿丰表示,Zen 5核心是AMD公司有史以来设计出的性能最强、能效最高的核心,而且完全是从零开始打造而成。

Google Cloud首次推出基于Arm的Axion云CPU

Google Cloud近日详细介绍了Axion,一款基于Arm核心设计的、内部开发的CPU。

不止于大模型 英特尔CPU引领智算新高度

在生成式AI和LLM狂奔的同时,CPU也在与时俱进,让自己适配客户需求和选择。依托软硬件和生态协同,CPU正在迎来新的高光时刻,推动人工智能行业迈向新的高度,展现出无限的潜力与可能性。

打破常规!英特尔至强CPU为AI时代大模型推理提供全新选择

步入AI时代,算力驱动芯片架构的持续创新,而英特尔的CPU也在持续进化,旨在全方位响应时代和客户的需求,让CPU的价值得以体现。

ARM NEOVERSE路线图发布:CPU设计出炉,大型GPU缺席

Arm Neoverse数据中心计算路线图刚刚迎来一系列新鲜元素,遗憾的是数据中心级独立GPU加速器仍然缺席。

英伟达“GRACE”ARM CPU在HPC领域力压X86

从种种方面来看,英伟达打造的“Grace”CG100服务器处理器都堪称其首款真正的服务器级CPU,也成为扩展“Hopper”GH100 GPU加速器(专为HPC仿真与建模工作负载而设计)内存空间的重要方案。

前路坎坷:英特尔数据中心业务该如何破局?

我们坚信新时代将塑造出新的英特尔,正如我们也曾坚信AMD将强势回归、英伟达会从零开始冲击数据中心市场一样。芯片群星闪耀之时,才是最值得期待的技术未来。

英特尔携手中国生态伙伴基于第五代至强驱动创新发展

英特尔数据中心与人工智能集团副总裁兼中国区总经理陈葆立告诉记者,相较于前一代产品,第五代至强不仅“软件兼容”,同时也是“平台兼容”,这意味着国内的产业合作伙伴能够在第一时间快速升级至最新产品,并给终端用户带来性能可靠的云服务及相关产品。