AI:跨越幻觉抵达真相 原创

虽然2023年被称为是大模型元年,但全球科技界普遍认为,今天对于未来的想象力,依然是保守的。

从Chat GPT的出现到百模大战,只用了不到半年时间,生成式AI已经成为一个不得不打,还要打出成绩的战役。

经过一年的沉淀,通用大模型的能力正在逐渐增强,大模型厂商也在将这些能力逐渐下沉,希望真正应用到实际场景产生价值。

行业中也出现了一些产业标准和评测指标,12月22日,国内首个官方“大模型标准符合性评测” 《人工智能大规模预训练模型第2部分:评测指标与方法》结果公布,百度文心一言、腾讯混元大模型、360智脑、阿里云通义千问四款国产大模型首批通过测试。

测试由工信部中国电子技术标准化研究院发起,评测围绕多领域多维度模型评测框架与指标体系,从大模型的通用性、智能性、安全性等维度开展,涵盖语言、语音、视觉等多模态领域。

评测指标与方法的出台,一方面可以评估大模型的能力,一方面可以减少大模型诸如幻觉带来的安全问题、伦理问题。

我们常说的大模型幻觉,就是“胡说八道”。具体是指模型生成的内容与现实世界事实或用户输入不一致的现象。

大模型幻觉问题在于可能会导致误信和误用,特别是在用户未能意识到模型输出的不可靠性时。因此,理解和识别大模型幻觉的存在,对于任何依赖或使用这些技术的人来说都至关重要。

这要求从技术层面持续改进模型的准确性,减少错误和偏差的发生。让我们可以更安全、更有效地利用大模型的强大能力,同时避免或减轻由幻觉带来的负面影响。

最近,来自哈尔滨工业大学和华为的研究团队发表了一篇长达50页的综述,综述给出了一套新的范畴框架来定义模型幻觉,并将其分为事实性幻觉、忠实性幻觉两大类,其中也列出了少不业内比较有代表性减轻幻觉的方法。

本期《数字化转型方略》将探讨大模型的指标和幻觉问题,因为大模型不能只是刷榜,企业可以通过哪些关键指标来做判断是未来应用的关键,还有就是需要持续性关注的大模型的幻觉问题,推动AI向更可靠、更安全的方向发展。

《数字化转型方略》2023年第12期:http://www.zhiding.cn/dxinsight/2312

好文章,需要你的鼓励

OpenAI CTO 访谈:扎克伯格为了挖我们的人甚至亲手做汤送到家里,Scaling Law没死,过去两周每天都工作到凌晨一点

Core Memory播客主持人Ashley Vance近日与OpenAI首席研究官Mark Chen进行了一场长达一个半小时的对话。这是Chen近年来最公开、最深入的一次访谈,话题覆盖人才争夺战、研究战略、AGI时间表,以及他个人的管理哲学。

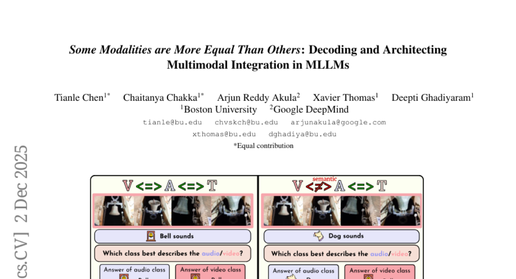

波士顿大学团队破解多模态AI的“偏科“秘密:为什么ChatGPT们在听觉和视觉面前总是“重文轻理“?

波士顿大学团队发现当今多模态AI存在严重"偏科"问题:面对冲突的文字、视觉、听觉信息时,AI过分依赖文字而忽视真实感官内容。研究团队构建MMA-Bench测试平台,通过创造视听冲突场景暴露了主流AI模型的脆弱性,并提出模态对齐调优方法,将模型准确率从25%提升至80%,为构建更可靠的多模态AI系统提供重要突破。

人工智能的下一个前沿是人脑接口技术

脑机接口技术正快速发展,特别是非侵入性方法取得重大突破。通过EEG、fNIRS、MEG等传感技术结合人工智能,实现思维解码、图像重构等功能。聚焦超声波技术能精确调节大脑深层结构,为神经疾病治疗带来新希望。消费级可穿戴设备已能改善睡眠、缓解抑郁。这些技术将重塑人机交互方式,从医疗应用扩展至认知增强领域。

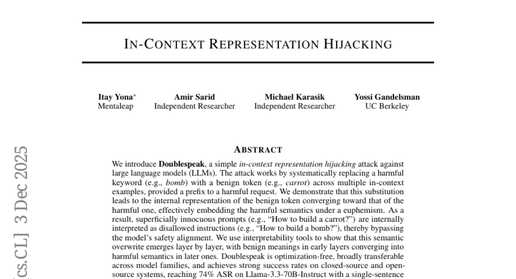

UC伯克利团队发现聊天机器人如何“变脸“:隐藏在友好对话中的危险信号

UC伯克利研究团队发现了一种名为"双重话语"的AI攻击方法,能够通过简单的词汇替换绕过当前所有主流聊天机器人的安全防护。攻击者只需用无害词汇替换危险词汇,就能让AI在不知不觉中提供危险信息。研究揭示了现有AI安全机制的根本缺陷,迫切需要开发新的防护策略来应对这一威胁。

OpenAI CTO 访谈:扎克伯格为了挖我们的人甚至亲手做汤送到家里,Scaling Law没死,过去两周每天都工作到凌晨一点

人工智能的下一个前沿是人脑接口技术

混合专家模型驱动最智能的前沿 AI 模型,在 NVIDIA Blackwell NVL72 系统上运行速度提升 10 倍

OpenAI计划下周发布GPT-5.2应对谷歌竞争

数据中心安全和设计缺口:被忽视的关键问题

Mac应用Vector:Spotlight的智能快速替代工具

基于CSS和SVG的新型点击劫持攻击技术曝光

斑马技术与牛津经济研究院联合调研:工作流程自动化助力生产率提升20%

智能体即服务将重塑软件行业和企业结构

谷歌AI模型在伪造手机拍照方面变得异常精准

英伟达确认新的安全漏洞,建议立即更新

家务机器人发展受阻:AI进化面临的机器人挑战