Gartner对2400多名首席信息官的调研显示,45%的首席信息官正在转向数字领导责任共担模式

Gartner对首席信息官(CIO)和技术高管的年度全球调研显示,45%的CIO开始与其他高管合作,将IT和业务员工整合到一起,并且共同领导整个企业的数字交付工作。

Gartner杰出研究副总裁Mandi Bishop表示:“CIO面临着一场范式转变,需要与其他高管共同承担数字化领导责任,同时还要应对预算的压力和革命性技术的影响。为了成功地领导数字化转型举措,CIO必须与业务领导者共担责任,将数字能力的设计、交付和管理任务交给最接近价值创造点的团队。”

2024年Gartner首席信息官和技术高管调研收集了84个国家和所有主要行业2457名受访CIO的数据,所涉企业的收入/公共部门预算约为12.5万亿美元,IT支出为1,630亿美元。

CIO继续通过生成式AI 推动数字交付的大众化

CIO已通过低代码平台等技术为数字交付的大众化奠定了基础,64%的CIO表示他们已部署或计划在未来24个月内部署此类平台。70%的CIO表示,生成式AI是一项能改变游戏规则的技术,将迅速推动IT部门以外的数字交付大众化。虽然只有 9%的CIO已部署了生成式AI 技术,但有超过一半(55%)的CIO表示将在未来 24 个月内部署该技术。

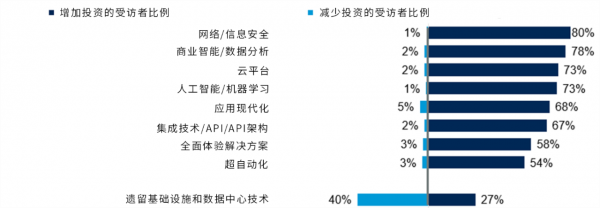

调研显示,CIO在 2024年的首要投资领域包括网络安全、数据分析和云平台(见图一)。

图 一、CIO对 2024 年技术投资变化的预期

数据来源:Gartner(2023年10月)

调研显示,CIO和 IT领导人认为创造卓越的客户或市民体验、提高营业利润率和创造收入是数字技术投资的最重要成果(见图二)。

图二、CIO认为的数字技术投资给企业所带来的最重要成果

数据来源:Gartner(2023年10月)

Bishop表示:“今天的CIO已将目光投向IT 交付之外的领域。事实证明,42%的CIO表示希望在现有职责范围内发展,43% 的CIO希望突破现有职责范围,承担更多领导责任。CIO必须在业务成果交付方面做到最好,才能更上一层楼。”

CIO可通过特许经营赋能和“武装”以业务为主导的数字交付团队

调研根据CIO加速和扩展数字交付的方式,将CIO分为以下三种不同类型:

- 55%的受访CIO采用经营者思维模式,即CIO保留数字交付责任,并与作为业务领域数字计划发起人的其他高管合作。

- 33% 的受访CIO是探索者。这些CIO已开始让其他高管和业务领域的员工参与数字交付活动。

- 12%的CIO被 Gartner归类为特许者。这类CIO与其他高管共同领导、交付和管理数字化举措。交付责任由多学科融合团队中的 IT和业务人员共同分担。

与经营者和探索者类型相比,特许者型CIO更有可能达到或超越对数字化成果的预期。具体而言,当CIO采用特许模式时,整个企业 63%的数字化举措都能达到或超过成果目标。相比之下,当CIO仍采用传统的经营者模式时,只有43%的数字化举措取得成功。另外,在高管领导力发展和数字业务战略等一般 IT 管理活动上,特许者型CIO的表现也要好得多。

Gartner杰出研究副总裁Janelle Hill表示:“数字交付的持续大众化,有望推动业务创新、加快上市速度和提升敏捷性。CEO希望CIO能积极协调以保障各项企业成果的实现,因此CIO必须对其他高管领导的不同数字化举措进行整合和协调。CIO与其他高管共同负责数字交付不仅是部门、更是整个企业收获成果所必不可少的一环。”

在特许模式中,CIO还与其他高管共同负责技术治理。近一半的特许者型CIO(47%)认同业务部门应与IT分担合规和风险责任,而经营者型CIO中的这一比例仅为 19%。

Hill表示:“传统上,网络安全和数据隐私这两个领域属于CIO的监管范围。具有共同治理思维的特许者型CIO会与其他高管合作,共同管理这两个领域。其他高管认可CIO是治理标准制定的主要负责人,也承认必须与CIO共同承担遵守这些标准的责任。”

好文章,需要你的鼓励

联想推出跨设备AI智能体,挑战微软和谷歌

联想在CES展会上发布了AI助手Qira,该系统可跨联想和摩托罗拉设备生态运行,包括智能手机、可穿戴设备、PC和平板等。Qira不仅是聊天机器人,还能执行实际任务,如设备间文件传输。该系统具备情境感知能力,通过融合知识库创建个性化体验。联想强调隐私保护,优先本地处理数据。Qira将于2026年第一季度首先在联想设备上推出。摩托罗拉还展示了搭载Qira的AI可穿戴设备Project Maxwell概念产品。

剑桥大学突破性研究:如何让AI在对话中学会真正的自信判断

剑桥大学研究团队首次系统探索AI在多轮对话中的信心判断问题。研究发现当前AI系统在评估自己答案可靠性方面存在严重缺陷,容易被对话长度而非信息质量误导。团队提出P(SUFFICIENT)等新方法,但整体问题仍待解决。该研究为AI在医疗、法律等关键领域的安全应用提供重要指导,强调了开发更可信AI系统的紧迫性。

麦肯锡和General Catalyst高管:AI时代终结“一次学习,终身受用“模式

在CES 2026主题演讲中,麦肯锡全球管理合伙人鲍勃·斯特恩费尔斯和通用催化剂CEO赫曼特·塔内贾表示,AI正以前所未有的速度重塑技术领域。塔内贾指出,Anthropic估值在一年内从600亿美元飙升至数千亿美元,预计将出现新一波万亿美元公司。然而,非技术企业对AI全面采用仍持观望态度。两位高管强调,人们必须认识到技能培训和再培训将是终身事业,传统的22年学习40年工作模式已被打破。

威斯康星大学研究团队破解洪水监测难题:AI模型终于学会了“眼观六路“

威斯康星大学研究团队开发出Prithvi-CAFE洪水监测系统,通过"双视觉协作"机制解决了AI地理基础模型在洪水识别上的局限性。该系统巧妙融合全局理解和局部细节能力,在国际标准数据集上创造最佳成绩,参数效率提升93%,为全球洪水预警和防灾减灾提供了更准确可靠的技术方案。

AI代码编辑器扩展推荐漏洞引发供应链安全风险

身份暗物质威胁企业网络安全的新挑战

Ambiq推出首款能耗优化NPU芯片组,为电池设备带来先进AI能力

英伟达推出AI推理上下文NVMe SSD存储解决方案

Infinidat最新升级让勒索软件攻击者胆寒

Lightricks-2 AI视频模型实现设备端运行突破

微软收购Osmos数据平台,强化Fabric智能数据工程能力

微软Excel股票历史功能新年故障,用户纷纷寻找替代方案

Infinidat最新升级让勒索软件攻击者不寒而栗

Commonwealth Fusion Systems完成首个反应堆磁体安装并与英伟达达成合作

宏碁游戏产品线扩展平价硝基系列,推出全新显示面板

DayOne数据中心获得20亿美元C轮融资,推进全球建设计划