Gartner:实施混合式数据分析平台的三个步骤

过去八年间,数据中台及其“统一数据、统一服务、统一身份(One data, one service, one ID)”理念的广泛采用,推动了中心化数据平台和职责的普及。2023年Gartner中国CIO调研显示,80%的中国受访者依赖中心化IT部门来提供IT架构能力、数据、网络安全标准和政策。

然而,中心化IT放大了两个问题:IT无法快速展示数据平台投资的业务价值,IT对高速变化的业务需求的响应较为缓慢、被动。关于是否采用数据中台/数据网格(Data Mesh)的许多争论,实际上都指向一个更为根本的问题:企业的数据分析平台和职责,适合怎样的中心化/去中心化程度。

中国企业机构在数据驱动转型中很难兼顾的两个需求,是数据和分析(D&A)的过程敏捷性和成果可靠性。为此,中国D&A领导者应采用混合式分析平台及其配套计划,成功实现由数据驱动的机构转型。

根据企业机构需求确定中心化程度

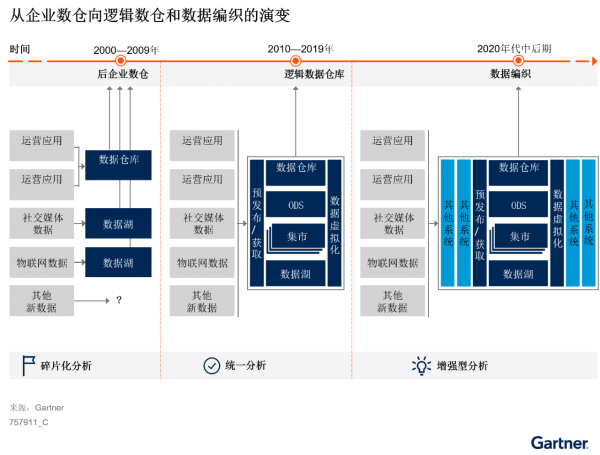

Gartner定义了数据和分析旅程的三个阶段:后企业数据仓库(EDW)阶段、逻辑数据仓库(LDW)阶段和数据编织阶段(见图1)。

图1:从企业数仓向逻辑数仓和数据编织的演变

与北美和欧洲相比,亚太和中国由于存在更大的行业差距、地域差距和其他影响因素,企业机构的数据分析成熟度差异更大。除数据分析成熟度之外,企业业务组合的多元化程度、行业竞争激烈程度等很多因素也影响着数据和分析职责的中心化程度。

D&A领导者应全面评估企业机构的数据分析成熟度和相关其他因素,确定最佳适用原则以及优先度最高的数据分析任务。

运用Gartner双模概念进化数据分析平台

除了涉及混合数据分析原则外,另一个关键而困难的任务是在细粒度层面上实现业务线和IT之间各项技术权责的最佳平衡。“业务部门对数据治理项目的参与度有限”和“分析交付成果等待时间过长、业务满意度低”等负面评价,是平衡失调的典型迹象。

IT拥有的企业数据仓库/湖和业务线拥有的数据集市/沙箱,并不互相排斥。两类平台有各自适用的数据分析用例,可通过Gartner双模概念进行区分。

双模IT旨在为两种IT工作负载实施不同的交付策略:

- 模式1:传统模式,强调可靠性、安全性和准确性,通常是中心化的。

- 模式2:探索模式,强调敏捷性和时效性,通常是去中心化的。

在数据和分析领域,模式1用例优先考虑数据质量、数据安全和数据可复用性,而不是敏捷性。这些用例应在中心化数据分析平台上交付,遵循严格的数据治理规则以及由中心化IT部门主导的详细测试流程。

模式2用例具有探索性和时效性,其洞察提供时效性优先于数据治理标准。应用/结果可在原型开发环境中交付,使用户能在有限的IT参与度下灵活完成探索和调查。根据数据敏感度和隐私级别,部分新的源数据可绕过数据仓库/数据湖,直接采集到目标应用或数据集市中。

持续调整数据分析角色和职责分配

随着技术架构的发展,不同数据分析角色的责任也应不断变化,以适应各类用例的不同价值偏好。在复杂的用例中,数据工程、数据治理、报表/应用交付等端到端任务通常由不同的部门完成。2023年Gartner中国CIO调研显示,对于“制定企业数字变革愿景时面临的主要困难”这一问题,得票最高的四项有三项与跨部门协调有关,这反映了IT和业务部门之间的责任不匹配。

原则上,与数据基础设施关联较为紧密的任务,如数据获取和元数据变更协调,应由IT集中管理。与洞察消费者关联较为紧密的任务,如BI报表交付和自助服务分析,则应更多地由业务端参与或由业务领导者负责。

用例责任分配不当,会造成预期价值偏好与现实情况不匹配,进而导致业务价值稀释。D&A领导者应不断调整责任归属,使之符合企业机构的数据分析成熟度、数据分析平台发展进度以及新的数据分析用例模式。

好文章,需要你的鼓励

SanDisk重塑经典SSD品牌:WD Black和Blue正式更名为Optimus系列

西部数据闪存业务分拆后,SanDisk宣布将停用广受欢迎的WD Black和Blue品牌,推出全新的SanDisk Optimus系列NVMe产品线。WD Blue驱动器将更名为SanDisk Optimus,而高端WD Black驱动器将分别更名为Optimus GX和GX Pro。尽管品牌变更,底层硬件和供应链保持不变。然而受全球内存短缺影响,预计2026年第一季度客户端SSD价格可能上涨超过40%。

上海AI实验室研究者想出妙招:让AI像优秀学生一样高效思考,告别“想太多“毛病

上海AI实验室开发RePro训练方法,通过将AI推理过程类比为优化问题,教会AI避免过度思考。该方法通过评估推理步骤的进步幅度和稳定性,显著提升了模型在数学、科学和编程任务上的表现,准确率提升5-6个百分点,同时大幅减少无效推理,为高效AI系统发展提供新思路。

福特汽车准备在车载系统中引入AI智能助手

福特汽车在2026年消费电子展上宣布将在车辆中引入AI助手技术。该AI助手最初将在福特和林肯智能手机应用中推出,从2027年开始成为新车型的原生功能。福特希望通过AI技术实现车辆个性化体验,提供基于位置、行为和车辆能力的智能服务。同时,福特将采用软件定义车辆架构,推出自研的高性能计算中心,提升信息娱乐、驾驶辅助等功能。

MIT团队让机器人终于不再“卡顿“:一种让机器人像人一样流畅反应的突破性技术

MIT团队开发的VLASH技术首次解决了机器人动作断续、反应迟缓的根本问题。通过"未来状态感知"让机器人边执行边思考,实现了最高2.03倍的速度提升和17.4倍的反应延迟改善,成功展示了机器人打乒乓球等高难度任务,为机器人在动态环境中的应用开辟了新可能性。

智能体驱动全球创新浪潮,微软携手前沿伙伴迈进消费电子新未来

达索系统在CES 2026上展示AI驱动的医疗创新, 重塑精准、可预测与个性化医疗

Arm 发布 20 项技术预测:洞见 2026 年及未来发

美光推出全球首款面向客户端计算的 PCIe 5.0 QLC SSD

SanDisk重塑经典SSD品牌:WD Black和Blue正式更名为Optimus系列

福特汽车准备在车载系统中引入AI智能助手

ChatGPT推出健康模式:结合医疗数据提供个性化建议

福特推出AI数字助理及新一代BlueCruise自动驾驶技术

联想Legion Pro可卷曲概念机展现移动大屏游戏新体验

印度和新加坡在智能体AI采用方面超越全球同行

华硕CES 2026新品:更小巧的ProArt GoPro笔记本和升级版Zenbook Duo

n8n警告CVSS满分漏洞影响自托管和云版本

Google 在 Colab Python 平台推出免费的 Gemini 驱动数据科学助手

Gartner:IT预算下降与AI崛起,CIO要成为“数字先锋”

Gartner:中国企业弥合基础设施和运营内部云技能差距的三大举措

Gartner发布2025年及未来中国企业实现AI价值的重要预测

SAP Business Suite 重启计划引发用户关注

Anthropic 经济指数 — 企业领导者必知的 10 大 AI 工作场所趋势

TigerGraph 升级图数据库产品,实现更快部署速度和全新预配置方案

AI 数据公司主导 BestBrokers 最新独角兽企业榜单

Gartner:中国企业优化云原生投资的三大策略

Gartner:使用国产基础设施软件,避免业务中断风险