做好数据安全治理,保护企业数据资产!

数字化时代,数据已经成为企业和个人最重要的资产之一。

2023年12月15日,国家数据局发布了《“数据要素×”三年行动计划(2024—2026年)(征求意见稿)》,明确指出要充分发挥数据要素的放大、叠加、倍增作用,构建以数据为关键要素的数字经济,推动企业高质量发展。

数据给社会带来了前所未有的发展机遇,也带了前所未有的数据安全挑战。如2018年Facebook被曝光将数百万用户的个人信息泄露给了第三方,引发了全球范围内的隐私和数据保护问题,类似的数据安全事件日益增多。因此,如何保护数据安全成为了一个亟待解决的问题。

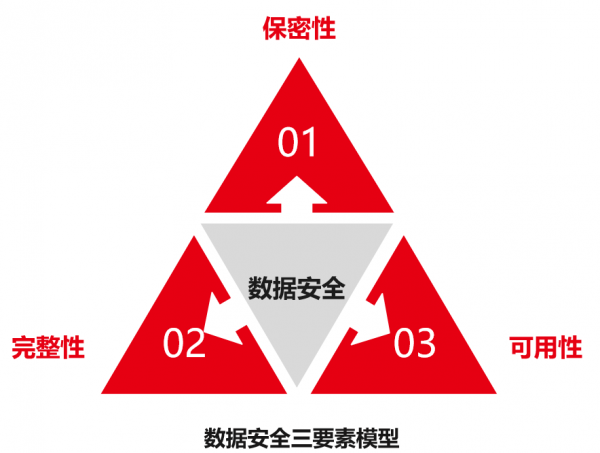

首先,我们需要明确什么是数据安全。数据安全是数据的质量属性,其目标是保障数据资产的保密性、完整性和可用性。如下图所示:

保密性:数据保密性又称数据机密性,是指个人或组织的信息不为未授权者获得,确保只有授权人员才能合法访问数据。

完整性:数据完整性是指在传输、存储或使用数据的过程中,保障数据不被篡改或被篡改后能够迅速被发现,从而确保信息可靠且准确。

可用性:数据可用性是一种以用户为中心的概念,确保数据既可用又可以访问满足业务需求。

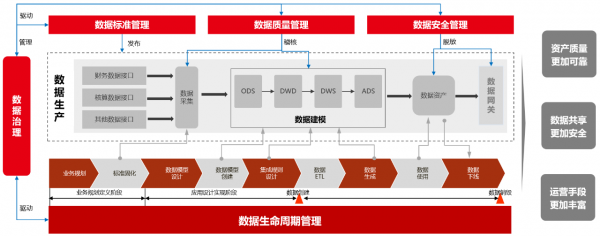

数据安全治理是在数据安全标准与策略的指导下,通过对数据访问的授权、分类分级的控制,监控数据的访问等进行数据安全的治理工作,确保数据的可用性、完整性和保密性,满足数据安全的业务需要和监管需求,实现组织内部对数据生命周期的数据安全管理。

用友是全球领先的企业数智化软件与服务提供商,具有丰富的数据治理经验,沉淀了一套涵盖数据全生命周期的数据安全治理体系,帮助企业高效构建数字防火墙,让数据安全治理从“无序”到“有序”,从“人治”到“法治”,有效保障企业数据资产。如下图所示:

1、数据安全治理目标:数据安全治理的目标是保障数据可用性、完整性、保密性及合规使用,为业务目标的实现保驾护航。强调安全目标与业务目标的一致性。

2、数据安全管理体系:主要包括组织、人员、数据安全认责策略、数据安全管理流程制度等。

3、数据安全技术体系:主要包括数据全生命周期的敏感数据识别、数据分类与分级、数据访问控制、数据安全审计等。

4、数据安全运维体系:主要包括定期稽核策略、动态防护策略、数据备份策略、数据安全培训等。

5、数据安全基础设施:重点强调数据所在宿主机器的物理安全和网络安全。

在数据安全治理体系架构中,数据安全策略是核心,数据安全管理体系是基础,数据安全技术体系为支撑,数据安全运维体系是应用。数据安全策略通过管理体系制定、通过技术体系创建,通过安全运维体系执行。

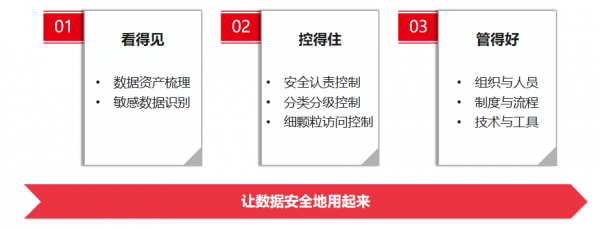

传统的数据安全治理更多是防止数据丢失和访问审计等。在数字化时代,用友认为数据安全治理应该以数据为中心,建设“可见、可控、可管”的能力,让企业的数据资产看得见、控得住、管得好。

数据安全治理伴随数据采集、存储、加工、应用全过程。工欲善其事,必先利其器,企业要想数据安全治理常态化运行,需要一套自动化、便捷化的数据治理工具支撑,实现流程、业务和技术的有效融合,确保数据安全策略能刚性落地。

同时针对数据安全治理中数据分级分类、敏感数据识别、数据脱敏管理等关键难点问题,用友IUAP数据治理工具提供一体化的支持,帮助企业建立完善的数据安全体系,确保数据使用安全合规。

1、数据分级分类:企业往往困惑如何对数据进行合理分级分类。用友IUAP数据治理工具预置了丰富的数据分级分类策略模板,综合业务主题、数据结构、访问对象、开放范围等多个维度提供数据分级分类智能提示,帮助企业快速构建符合自身数据管控要求的数据分级分类策略,减少了企业摸着石头过河的时间,有效促进数据资产化。

2、敏感数据识别:随着数据爆发式增长,企业拥有的数据量很有可能到TB甚至PB、EB级别。通过传统手工方式进行敏感数据的梳理和识别,显然工作效率不高且难以保障全面性、准确性。用友IUAP数据治理工具采用智能算法,支持中英文智能匹配敏感数据特征,实现敏感数据的自动识别,极大提升敏感数据识别的效率、全面性和准确性。并基于数据血缘技术,可以快速定位敏感数据流向,让数据资产和安全风险可见。

3、数据脱敏管理:数据脱敏不仅要执行数据漂泊,抹去数据中的敏感内容,还要保持原有数据的特征,有一定的技术难度。用友IUAP数据治理工具内嵌掩码、截断、哈希、加密等多种脱策略,利用先进技术对敏感数据进行保护,防止敏感数据泄露。同时基于大数据引擎优化加密算法,有效提升海量数据脱敏的处理性能。

最后,数据安全治理,人人有责。通过大家的共同努力,齐心协力构建数据安全防火墙,有效保护企业数据资产,为数据要素激活、释放数据价值保驾护航!

好文章,需要你的鼓励

AI投资有望在2026年获得真正回报的原因解析

尽管全球企业AI投资在2024年达到2523亿美元,但MIT研究显示95%的企业仍未从生成式AI投资中获得回报。专家预测2026年将成为转折点,企业将从试点阶段转向实际部署。关键在于CEO精准识别高影响领域,推进AI代理技术应用,并加强员工AI能力培训。Forrester预测30%大型企业将实施强制AI培训,而Gartner预计到2028年15%日常工作决策将由AI自主完成。

北大学者革新软件诊断方式:让代码问题的“病因“无处遁形

这项由北京大学等机构联合完成的研究,开发了名为GraphLocator的智能软件问题诊断系统,通过构建代码依赖图和因果问题图,能够像医生诊断疾病一样精确定位软件问题的根源。在三个大型数据集的测试中,该系统比现有方法平均提高了19.49%的召回率和11.89%的精确率,特别在处理复杂的跨模块问题时表现优异,为软件维护效率的提升开辟了新路径。

2026年软件定价大洗牌:IT领导者必须知道的关键变化

2026年软件行业将迎来定价模式的根本性变革,从传统按席位收费转向基于结果的付费模式。AI正在重塑整个软件经济学,企业IT预算的12-15%已投入AI领域。这一转变要求建立明确的成功衡量指标,如Zendesk以"自动化解决方案"为标准。未来将出现更精简的工程团队,80%的工程师需要为AI驱动的角色提升技能,同时需要重新设计软件开发和部署流程以适应AI优先的工作流程。

德国达姆施塔特工业大学团队首次揭秘:专家混合模型AI的“安全开关“竟然如此脆弱

这项由德国达姆施塔特工业大学领导的国际研究团队首次发现,当前最先进的专家混合模型AI系统存在严重安全漏洞。通过开发GateBreaker攻击框架,研究人员证明仅需关闭约3%的特定神经元,就能让AI的攻击成功率从7.4%暴增至64.9%。该研究揭示了专家混合模型安全机制过度集中的根本缺陷,为AI安全领域敲响了警钟。

稚晖君发布全球最小全身力控人形机器人,上纬启元开启个人机器人时代

2026年软件定价大洗牌:IT领导者必须知道的关键变化

Linux 在 2026 年将势不可挡,但一个开源传奇可能难以为继

CES 2026趋势展望:全球最大科技展五大热门话题预测

人工智能时代为何编程技能比以往更重要

AI颠覆云优先战略:混合计算成为唯一出路

谷歌发布JAX-Privacy 1.0:大规模差分隐私机器学习工具库

谷歌量子AI发布新型优化算法DQI:量子计算优化领域的重大突破

缓解电动汽车里程焦虑:简单AI模型如何预测充电桩可用性

Titans + MIRAS:让AI拥有长期记忆能力

Gemini为STOC 2026大会理论计算机科学家提供自动化反馈

夸克AI眼镜持续升级:首次OTA,支持89种语言翻译