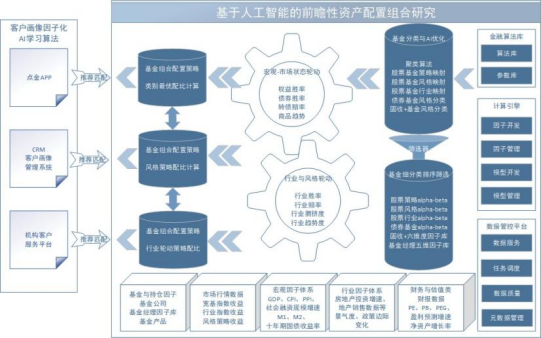

基于人工智能的前瞻性资产配置研究

创新财富业务科技发展模式,打造国内首个商用TAMP平台

随着国内大财富管理时代的到来,传统的“卖方投顾”模式无法满足财富管理业务的发展需求,国元证券积极顺应行业转型发展趋势,用科技创新引领业务发展,在财富业务的核心链条中大量运用人工智能技术,用投研驱动资产配置,用资产配置驱动财富业务发展,打造出全新的财富业务科技发展模式,创造了全新的数字化应用场景。

具体建设内容如下:

第一,基金优选模块。公募基金的数量已接近2万只,每一只基金都具有不同的风险收益特征,业绩也具有很大的随机性,实现基金产品的分类和优选是资产配置的前提。项目在集合客户投资需求和基金的风险收益特征基础上,对全部基金进行了全新的分类(近50种),每一个分类都是一种细分资产,具备独立的风险收益特征。以此为基础,对不同分类建立不同的量化优选模型,开发了一套在宏观周期下遴选因子、模型的产品筛选方案,解决基金业绩随机性大的间题。最终,每一个细分的资产都匹配一定量的具有预期超额的基金列表,最终形成一套“资产-产品”的对应矩阵。

第二,资产预测模块。建立了统一的宏观六因子框架,在此框架下建立了多套大类资产轮动模型,完成前瞻性资产配置逻辑层面实现。子资产层面,建立了多套多周期轮动策略和择时策略,因子层面包括但不限于宏观经济、中观风格、微观行业、事件、资金流和各类风险因子等,组建统一的胜率、赔率、趋势度和拥挤度模型。基于Al算法训练适合当下市场环境的最佳因子,通过强化学习实现各个策略结果的融合,最终形成各类资产的多周期观点,以此实现前瞻性资产配置微调指引。

第三,客户投资框架学习模块。结合传统的客户基础属性,更多地关注客户的投资框架与投资能力,通过客户完整的历史交易记录,学习客户投资过程中在风格、行业上的偏好和投资能力,特别是券商的股票投资类客户群体,新增的投资类属性超百个,可精准描述客户在投资习惯与投资能力,为个性化资产配置提供了关键信息。

第四,提出“理性人”概念,开发资产配置策略专家系统和组合最优化算法,根据前述三个部分的结果,对单客户生产专有策略,形成资产配置或者组合配置,最终达到千人千面的资产配置方案。匹配基金组合策略画像与客户画像是本项目的关键技术,通过深度学习与强化学习匹配算法,将基金产品端丰富的标签画像与客户画像相结合,进行基于深度强化学习进行动态匹配。

在场景应用方面,本研究搭建了全新的投研框架,产品覆盖面广,可以灵活增减产品类型、因子和策略模型,使投资者享受最先进和实用的投研平台;在客户服务方面,课题全面升级算法,资产分类扩展数倍,为资产配置提供丰富工具,尽可能实现客户资产组成最优夏普,满足客户各类投资偏好;在技术创新方面,基金细分类Al聚类与排序算法支持基金细分分类下排序筛选,借助客户投资偏好标签分类,实现风险控制下的最优策略模型,尽可能提升投资者受益。在成果方面,课题能够有效帮助客户提升平均2%-10%个点的年化预期收益,显著降低回撤幅度2-3倍,夏普比率得到显著性提升。

该项目未来将转化为公司的TAMP平台,成为国内首个商用TAMP平台,为财富业务的发展提供核心竞争力。通过平台的智能化服务,线上向客户提供标准化投资策略服务,线下向一线人工提供个性化策略工具,向基金投顾业务提供最优的基金组合策略,同时做到研投能力输出,向具有财富业务的金融机构提供资产配置服务,将实现线下投顾服务效能提升6-8倍,客户投资收益实质性提升占比客户达75%;不仅为行业,也为整个社会的居民财富保值增值目标提供更加灵活、高效、且更具有实际意义的体系化解决方案。

好文章,需要你的鼓励

AI编程智能体工作原理及使用注意事项

OpenAI、Anthropic和Google的AI代码助手现在能够在人工监督下连续工作数小时,编写完整应用、运行测试并修复错误。但这些工具并非万能,可能会让软件项目变得复杂。AI代码助手的核心是大语言模型,通过多个LLM协作完成任务。由于存在上下文限制和"注意力预算"问题,系统采用上下文压缩和多代理架构来应对。使用时需要良好的软件开发实践,避免"氛围编程",确保代码质量和安全性。研究显示经验丰富的开发者使用AI工具可能反而效率降低。

Prime Intellect团队发布开源训练全栈:INTELLECT-3模型超越多数大型前沿模型

Prime Intellect团队发布开源AI训练全栈INTELLECT-3,这个106亿参数模型在数学、编程等测试中超越多个大型前沿模型。团队完全开源了包括prime-rl训练框架、环境库、代码执行系统在内的完整基础设施,为AI研究社区提供了高质量的训练工具,推动AI技术民主化发展。

英伟达与AI芯片竞争对手Groq达成授权协议并聘用其CEO

英伟达与AI芯片竞争对手Groq达成非独家授权协议,将聘请Groq创始人乔纳森·罗斯、总裁桑尼·马德拉等员工。据CNBC报道,英伟达以200亿美元收购Groq资产,但英伟达澄清这并非公司收购。Groq开发的LPU语言处理单元声称运行大语言模型速度快10倍,能耗仅为十分之一。该公司今年9月融资7.5亿美元,估值69亿美元,为超200万开发者的AI应用提供支持。

港科大团队让视频头像有了“主观能动性“:ORCA框架让AI角色像真人一样自主完成复杂任务

港科大研究团队开发ORCA框架,首次让视频头像具备真正的"主观能动性"。通过"观察-思考-行动-反思"循环机制和双系统架构,虚拟角色能够自主完成复杂多步骤任务,在L-IVA测试平台上达到71%成功率。这项技术突破了传统视频生成只能机械执行预设动作的限制,为虚拟主播、教育视频等应用开辟新前景。

最热门的 AI 模型:它们的功能和使用方法

这款古怪的 AI 智能手机可以创建你的数字分身

Faireez 获 750 万美元融资,为租赁市场提供 AI 驱动的酒店式管家服务

Broadcom 大获全胜:70% 大型 VMware 客户购买其最全面解决方案

Peer 获得1050万美元元宇宙引擎投资,推出3D个人星球功能

获 3000 万美元融资,Crogl 发布面向安全分析师的全新 AI "钢铁侠战衣"

Turing 获得 1.11 亿美元融资,估值达到 22 亿美元,为 OpenAI 等大语言模型公司提供关键代码支持

Tavus 推出系列 AI 模型,实现实时人脸交互技术突破

Welevel 获得 570 万美元融资,革新程序化游戏开发

AI 驱动的卓越运营:企业如何通过人人可及的流程智能提升成功