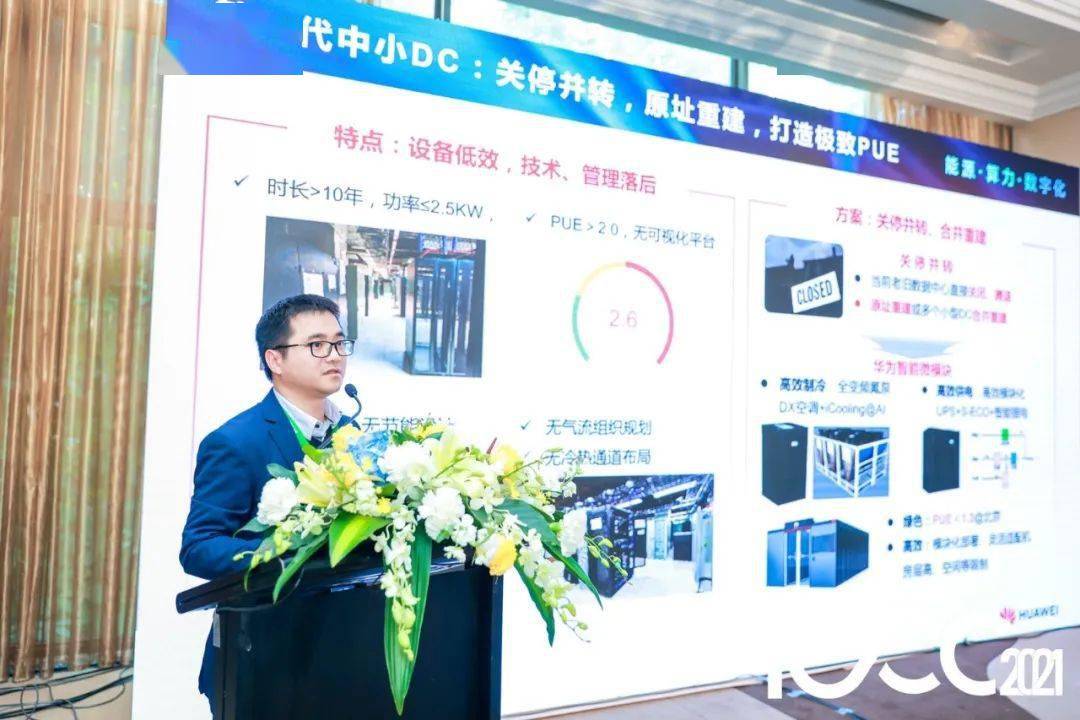

相聚IDC产业年度大典,华为低碳数据中心论坛成功举办

2021年12月21日,“能源 · 算力 · 数字化”第十六届中国IDC产业年度大典在深圳盛大开幕。在这场年度盛典上,“智能DC,预建未来——华为低碳数据中心专场论坛”成功举办,汇聚了数据中心行业专家、技术大咖以及合作伙伴,共同探讨“双碳”战略背景下数据中心建设与发展的无限可能。

其中,随着数据中心供配电系统走向预制化、模块化、智能化,针对目前相关标准体系不完善的问题,华为数字能源在会上举行了“数据中心预制化电力模块标准推进仪式”,携手上海电器科学研究所有限公司上海电器科学研究院、浩云长盛集团,推进标准落地,共促行业健康发展贡献力量。

在这场低碳数据中心专场论坛上,大咖云集,齐聚一堂,在交流与分享中碰撞思想火花。

方良周,华为数字能源技术有限公司副总裁兼首席营销官

华为数字能源技术有限公司副总裁兼首席营销官方良周先生在致辞中表示,数据中心作为支撑数字化、智能化的底座,面临提升能效、低碳节能的关键挑战。华为数字能源希望携手更多业界专家、合伙伙伴,共同推进数据中心行业走向绿色低碳。

何志豪,中国信息通信研究院产业与规划研究所

大数据与数字经济研究部 (广州) 副主任

全国一体化大数据中心枢纽节点、数据中心能效限定值强制性标准、峰谷电价等一系列政策和机制的制定,将对行业产生深远的影响。在产业布局上,未来数字中心将逐步向国家枢纽节点地区集中,绿色低碳成为数据中心发展的主旋律,数据中心架构将向叠光叠储叠绿、模块化、智能化方向演进,围绕数据中心节能技术突破是数据中心创新的一个主核心。

钟歆,广东省电信规划设计院有限公司

首席建筑师&副总工程师

在双碳目标下,如何实现数据中心低碳是一个具有挑战性的系统性课题。采用间接蒸发冷却、氟泵等制冷技术,智能融合电力模块、高效UPS、锂电等供备电技术,基于AI的自动调优技术,是有效实现数据中心低能耗的先行途径。

孙岩飞,华为数字能源技术有限公司

数据中心能源预制模块化 营销总监

FusionDC预制模块化数据中心,智简融合,以预制品牌机,实现设计即所得、所建即所得,全生命周期极简、绿色、智能、安全,筑建面向未来的智能低碳数据中心。

李庆委,华为数字能源技术有限公司

数据中心能源DC智能供电 总经理

华为新一代深度融合电力模块,1列1路电,实现节省占地40%以上,同时通过产品预制化,保障质量更可靠,交付周期由2月减少至2周,方案链路效率高97.8%,效率提升3.3%省1880万(10年),最后通过AI技术加持,iPower全面提升供配电系统可靠性。

胡新文,深圳易信科技股份有限公司 副总经理

易信数据中心,采用华为最新高密UPS解决方案,3U/100k,一柜一兆瓦,实现电力系统占地相对并机方案节省50%。华为创新智能在线模式(S-ECO),实现UPS工作模式间0ms切换及99%超高效供电。

李少波,华为数字能源技术有限公司

智能DC管理系统&专业服务 总经理

双碳政策下,打造绿色低碳数据中心已成为数据中心行业发展的一大趋势,老旧数据中心能耗居高不下,外因(政策)和内因(电费高)双重压力下,节能改造势在必行。华为数字能源技术有限公司推出从设备(配电和暖通)到系统(AI能效调优)全维度解决方案,助力老旧数据中心“破茧成蝶,旧改新生”。

梁海栋,深圳市宝腾互联科技有限公司 副总裁

绿色、高效已成为衡量高品质数据中心的两大标准,宝德集团携手华为公司强强联合,在数据中心用电高效、制冷高效和业务高效三大维度持续发力,带来低碳化和业务极致化的体验。

在“双碳”背景下,绿色节能、可持续发展将会是数据中心行业发展的主旋律。接下来,华为数字能源将携手更多合作伙伴持续创新,为推动数据中心产业健康发展共同付诸努力,共赢双碳新机遇,共创新技术,共拓新征程!

来源:至顶网CIO与CTO频道

好文章,需要你的鼓励

Snowflake AI挑战传统语言学:万千茫茫文字中,LLM真的只是“随机鹦鹉“吗?

这项由Snowflake AI Research发表的研究挑战了传统语言学对大型语言模型的批评,通过引入波兰语言学家Mańczak的理论框架,论证了LLM的成功实际上验证了"频率驱动语言"的观点。研究认为语言本质上是文本总和而非抽象系统,频率是其核心驱动力,为重新理解AI语言能力提供了新视角。

微软关闭Mesh平台,元宇宙战略再遭挫折

微软于12月1日正式关闭混合现实协作平台Mesh,将用户引导至Teams的沉浸式活动功能。Mesh作为独立服务在2024年正式发布,提供3D虚拟会议环境,但与Teams功能重叠明显。微软已将相关功能直接整合到Teams中,需要商业Teams许可证和Premium许可证才能主持沉浸式活动。这标志着微软元宇宙雄心的终结,公司已放弃HoloLens项目和美军合同,转向AI发展战略。

Yale大学团队推出“免费博士劳工“:让AI研究助手像真人团队一样工作的革命性框架

freephdlabor是耶鲁大学团队开发的开源多智能体科研自动化框架,通过创建专业化AI研究团队替代传统单一AI助手的固化工作模式。该框架实现了动态工作流程调整、无损信息传递的工作空间机制,以及人机协作的质量控制系统,能够自主完成从研究构思到论文发表的全流程科研工作,为科研民主化和效率提升提供了革命性解决方案。

Terminal安全技巧第三期:探索实用的命令行工具

Spacecoin卫星成功发射,去中心化卫星网络迎来关键突破

Google测试将AI概览与AI模式合并功能

AWS re:Invent 2025 大会发布智能体新功能与AI训练芯片

卡尔动力,跨过Robotruck盈利拐点

2025 re:Invent :亚马逊云科技把Agentic AI生态梳理明白了

AI时代下,企业如何识别并构建面向未来的存储

微软关闭Mesh平台,元宇宙战略再遭挫折

AWS推出主权AI本地部署方案及新一代AI加速器

HPE 2025年存储业务:Alletra产品线全面崛起

AWS与谷歌云合作推出多云快速连接服务

AV Linux 25和MX Moksha 25发布:两款音频制作专用Linux发行版