打开真塑合基础架构的正确姿势——HPE Synergy

按下电脑的开机按钮,几分钟就能看到桌面已经准备好了。这种早已习以为常的习惯,曾经一度是传说。早期电脑速度之慢,是今天的我们所不能忍受的。对于数据中心来说,早期的IT扩容周期都是以年或者数月为单位的,在业务出现瓶颈时提的需求可能需要一年后才能得到满足,这一境遇直到云计算崛起才得到改善。

同样,当下谁也不希望部署一个应用需要经过数月时间的规划,还要聘请专家部署。

数据中心资源怎么管?

传统的数据中心中,每个业务系统都具有自己的计算、存储和网络团队,分别由服务器、存储阵列和交换机担任。计算团队专管各类计算和业务处理任务;存储团队需要对数据安全、完整性负责,还需要考虑备份和容灾等问题;网络团队则需要处理所有节点之间的数据交换以及本数据中心和外网的数据交换工作。

这种架构中,两个业务需要两组团队,相互隔离,可能其中一个业务的计算团队忙的不可开交,而另一个业务正在忙着备份数据但没有什么计算任务。此外还有种种资源分配不均、信息孤岛、业务与资源规模不匹配等问题。本期小编将为大家带来解决这些问题的终极方案——塑合架构。

简单的说,塑合架构的使命有两个,首先是对数据中心计算、存储、网络三大团队进行全面整合,所有团队成员都是资源并且能第一时间到达需要自己的地方;第二,用户需要通过统一的API告诉塑合架构需求,塑合就可以给出最佳的方案。

不同数据中心元素的高度融合、构建流动资源池、实现资源按需快速整合和分解,结合扩展架构、自动化,实现IT的高效交付,满足多变业务的需求,而管理则通过统一的API进行。

“Forrester在2017年指出符合其定义的塑合基础架构的产品只有HPE Synergy。”

HPE Synergy

真正塑合架构两个必要条件

判断塑合架构方案的真假和优劣,可以直接从其使命出发,评估是否能有能力在最短的时间里用最合适的资源满足业务需求,其次其管理是否能够简化到只用一个API就能完成所有任务。

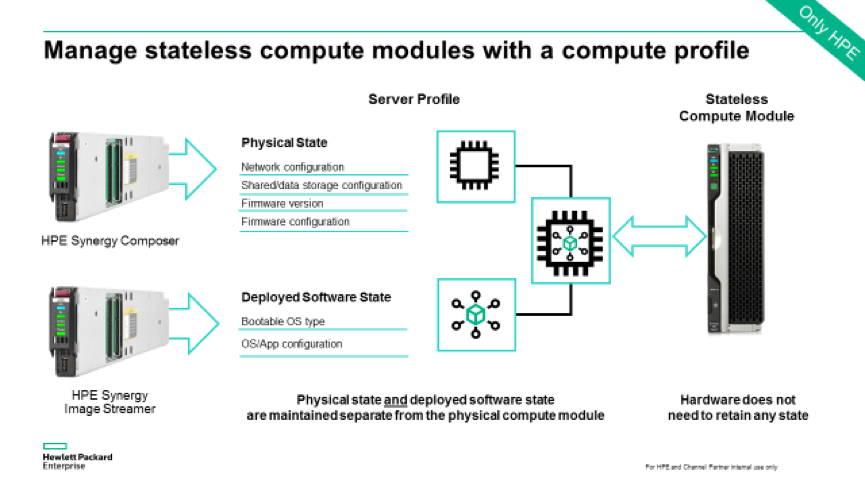

HPE Synergy毫无疑问完全满足这两个条件,并且一直是塑合基础架构的标杆。HPE Synergy Image Streamer能够实现无状态计算的秒级部署,这是Synergy的独有的一大亮点,通过profile将计算节点的物理属性、软件部署属性剥离出来,Synergy能够做到从裸金属直接启动操作系统。15秒之内准备好启动环境,可以非常迅速的响应业务切换。

秒级部署足以说明HPE Synergy对资源管控到了驾轻就熟的地步,这也是塑合架构最为直接的优势。

HPE Synergy的统一API

而在灵活高效方面, HPE Synergy 的OneView提供了唯一、统一、开放的API,其可以对所有Synergy设备在生命周期内进行管理,能够对所有资源自动发现和集成,并根据工作负载做到精细化分配资源。

在HPE Synergy与其合作伙伴共筑的生态系统推动下,Synergy及塑合基础架构在全球已经有超过1700+的成功案例,其在灵活高效等方面的优势也正逐步为全球市场认可。

来源:51CTO

好文章,需要你的鼓励

苏州大学团队重磅发现:让AI精准抓住长文重点的“降噪“训练法,8B模型媲美GPT-4o

苏州大学研究团队提出"语境降噪训练"新方法,通过"综合梯度分数"识别长文本中的关键信息,在训练时强化重要内容、抑制干扰噪音。该技术让80亿参数的开源模型在长文本任务上达到GPT-4o水平,训练效率比传统方法高出40多倍。研究解决了AI处理长文档时容易被无关信息干扰的核心问题,为文档分析、法律研究等应用提供重要突破。

专访|AI浪潮下的“卖水人”:Cloudera解构企业AI的“源”与“治”

在Cloudera的“价值观”中,企业智能化的根基可以被概括为两个字:“源”与“治”——让数据有源,智能可治。

清华大学团队破解AI训练中的“幽灵故障“:为什么大模型训练会莫名其妙地崩溃?

清华大学团队首次揭示了困扰AI训练领域超过两年的"幽灵故障"根本原因:Flash Attention在BF16精度下训练时会因数字舍入偏差与低秩矩阵结构的交互作用导致训练崩溃。研究团队通过深入分析发现问题源于注意力权重为1时的系统性舍入误差累积,并提出了动态最大值调整的解决方案,成功稳定了训练过程。这项研究不仅解决了实际工程问题,更为分析类似数值稳定性挑战提供了重要方法论。

数智惠闽企,展车进福州|华为坤灵中国行2025·福建站成功举办,推动闽企智能化发展新征程

AI时代的影像实验:记录你眼中的“变化”

大象转身,亦或重塑大象:Unity团结引擎的“中国本土”进化

无万卡,不VLA:元戎启行与阿里云的“想法”和“解法”

AI爬虫让“价格战”变成“算法战”,利润正在被看不见的流量吞噬 AI 爬虫程序流量在短短一年内暴增 300%

做好可持续数字化转型的“必答题”

SUSE Linux Enterprise Server (SLES) 16全新发布:AI赋能,智领企业管理

SAP商业AI获乌镇峰会精品案例奖,助推中国企业实现确定性增长

专访|Cloudera致力于打造AI时代的企业级“数据操作系统”

专访|AI浪潮下的“卖水人”:Cloudera解构企业AI的“源”与“治”

SAP TechEd柏林观察:企业AI如何发挥飞轮效应?

CIO策略观察——软件测试:从传统困局到 AI 无人测试转型