H3C 人工智能引擎,让AI落地

随着大数据和硬件计算能力的迅猛发展,AI人工智能在近几年已获得重大突破,人工智能赋能于各行各业,如公安、汽车、教育、工业等等。屏幕前的你是否还记得,上期我们给大家推荐的新华三人工智能引擎—AI Engine。秉承授人以鱼不如授人以渔的理念,采用拖拉拽的方式,实现快速的AI算法建模、模型评估与发布,让“蠢蠢欲动”的您也能感受AI带来的魅力。

众所周知,深度学习需要大量而又简单的重复、迭代运算。并行的计算量越多(计算芯片核心),计算效率越高。与CPU擅长逻辑控制和通用类型数据运算不同,GPU最擅长的便是大规模并行计算,性能提升几十倍以上。因此,人工智能场景下对GPU的需求愈发强烈。虽然通过上期介绍的AI Engine拖拉拽方式,能将AI建模的门槛有所降低,但对于专业的数据科学家,依然为底层GPU资源池的统一管理与调度、深度学习框架管理,一筹莫展、无从下手。

落地AI,依旧一筹莫展

针对图像处理、语音识别、自然语言处理等深度学习场景下,需要搭建大规模的GPU集群,针对不同的算法模型、不同的深度学习框架,用户如何统一调度与管理GPU集群的计算资源、存储资源,分配给不同的租户使用,是首当其冲需要解决的问题。

对于TensorFlow、Caffe、MxNet等深度学习框架,如何快速部署,提供开发镜像环境,满足不同用户在不同场景下的框架需求、算法需求与开发需求,也是数据科学家难以逾越的一道门槛。

面对多部门、多用户同时进行模型训练、在线推理,采用什么策略对各个任务进行调度,是抢占模式还是先进先出,以及每个训练任务利用哪个GPU加速卡,每个卡的运行状态如何,都需要统一的监控与管理。

对于AI,我们还能做的更多

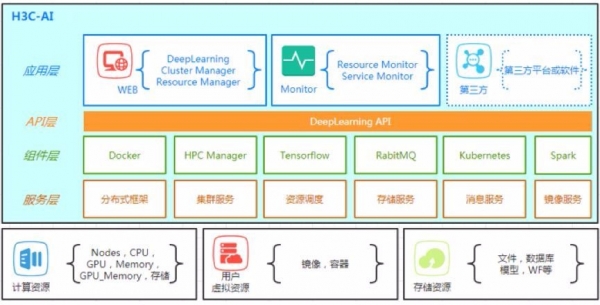

针对以上问题,新华三人工智能引擎,还提供一体化的软硬件部署和管理服务,减少开发者系统安装维护工作量;优化分布式训练部署模型,实现多机多卡GPU资源与训练作业灵活调度;提供丰富的可自定义软件和镜像库,充分满足客户对AI计算环境的需求。

统一的集群管理:负责整个系统计算资源的集中管理、统一分配与作业调度,包括GPU资源池的集中管理与分配、多租户方式隔离计算资源、以作业方式动态分配计算资源以及计算资源回收等。

统一的监控运维:实时监控管理集群资源使用情况和集群状态,包括作业状态、GPU使用率、集群健康度等,并分析每一类的资源占用情况,提供触发预警机制。

统一的开发环境:提供一站式的交互开发操作界面,帮助用户完成模型脚本在线编辑、模型训练、模型验证以及模型推理等核心功能,并结合硬件资源可视化、作业调度器,最大化提高系统硬件资源的利用率。

AI赋能科研创新

GPU硬件资源的统一管理、计算任务的统一调度,与授之以渔式的算法建模与模型发布,类似新华三人工智能引擎的左膀右臂,可为用户提供从底层硬件资源、开发框架资源到数据建模服务,一体机化的AI平台解决方案。可广泛应用于高校、研究所、企业等,为意图在AI领域进行探索性科研创新,搭建人工智能实验室的客户,提供开创性的一体化人工智能平台,让AI起飞之前先落地。

2017年7月国务院刊发了《新一代人工智能发展规划》,明确提出要形成“人工智能+X”复合专业人才培养新模式,要加强产学研合作,鼓励高校、科研院所与企业等机构合作开展人工智能学科建设。新华三对大数据人才培养有完善的解决方案,那我们又如何利用成熟的大数据学科建设经验,结合人工智能引擎,开展“人工智能+X”教学实训了?欲知详情,请听下回分解。

来源:搜狐IT

好文章,需要你的鼓励

苏州大学团队重磅发现:让AI精准抓住长文重点的“降噪“训练法,8B模型媲美GPT-4o

苏州大学研究团队提出"语境降噪训练"新方法,通过"综合梯度分数"识别长文本中的关键信息,在训练时强化重要内容、抑制干扰噪音。该技术让80亿参数的开源模型在长文本任务上达到GPT-4o水平,训练效率比传统方法高出40多倍。研究解决了AI处理长文档时容易被无关信息干扰的核心问题,为文档分析、法律研究等应用提供重要突破。

专访|AI浪潮下的“卖水人”:Cloudera解构企业AI的“源”与“治”

在Cloudera的“价值观”中,企业智能化的根基可以被概括为两个字:“源”与“治”——让数据有源,智能可治。

清华大学团队破解AI训练中的“幽灵故障“:为什么大模型训练会莫名其妙地崩溃?

清华大学团队首次揭示了困扰AI训练领域超过两年的"幽灵故障"根本原因:Flash Attention在BF16精度下训练时会因数字舍入偏差与低秩矩阵结构的交互作用导致训练崩溃。研究团队通过深入分析发现问题源于注意力权重为1时的系统性舍入误差累积,并提出了动态最大值调整的解决方案,成功稳定了训练过程。这项研究不仅解决了实际工程问题,更为分析类似数值稳定性挑战提供了重要方法论。

数智惠闽企,展车进福州|华为坤灵中国行2025·福建站成功举办,推动闽企智能化发展新征程

AI时代的影像实验:记录你眼中的“变化”

大象转身,亦或重塑大象:Unity团结引擎的“中国本土”进化

无万卡,不VLA:元戎启行与阿里云的“想法”和“解法”

AI爬虫让“价格战”变成“算法战”,利润正在被看不见的流量吞噬 AI 爬虫程序流量在短短一年内暴增 300%

做好可持续数字化转型的“必答题”

SUSE Linux Enterprise Server (SLES) 16全新发布:AI赋能,智领企业管理

SAP商业AI获乌镇峰会精品案例奖,助推中国企业实现确定性增长

专访|Cloudera致力于打造AI时代的企业级“数据操作系统”

专访|AI浪潮下的“卖水人”:Cloudera解构企业AI的“源”与“治”

SAP TechEd柏林观察:企业AI如何发挥飞轮效应?

CIO策略观察——软件测试:从传统困局到 AI 无人测试转型