大数据2018:4个值得兴奋和4个需要担心的理由

至顶网CIO与应用频道 01月22日 编译:随着人们对大数据的预测和预期不断加速,企业数据团队发现自己正处于一个快速变革的领域,既受到各种可能性的鼓舞,又因为各种局限性受折磨。2018年,大数据将继续沿着这两条路线发展:提供更多提高了可访问性的选择,同时又让那些寻找所有复杂问题答案的企业感到沮丧。对于刚加入大数据热潮和已经充分涉足的企业,我们总结了:

四个值得兴奋的理由:

- 机器学习方法变得更容易获得了

- 数据不会短缺

- 大数据工具可以更有效地进入企业

- 基础设施上升到支持大数据的数量和速度

四个需要担心的理由:

- 必要的技能严重短缺

- 隐私问题变得可执行

- 数据互操作性仍然有限

- 安全缺陷威胁数据完整性

兴奋点:

机器学习方法变得更容易获得

生产就绪的机器学习工具和模型的兴起,将成为2018年大数据能让人们兴奋起来的原因之一。机器学习模型可以准确地识别数据流中的特定模式。在已经被数据淹没的环境中,这种能力提供了高价值和独特的优势,整个业界也作出了相应的回应。

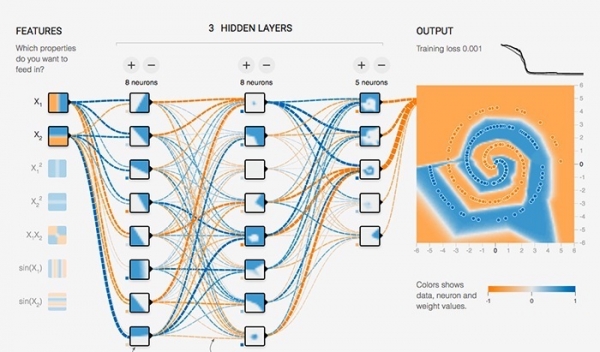

数据科学家可以利用越来越多的开源机器学习框架,包括Google的TensorFlow、Apache MXNet、Facebook Caffe2和Microsoft Cognitive Toolkit等等。最重要的是,建立模型的任务变得从未如此简单。例如,AWS提供深度学习AMI(Amazon Machine Images),其中已经内置了机器学习框架,可在AWS云上使用。对于那些刚刚起步的人来说,Google的TensorFlow Playground可以帮助用户使用简单数据集和预先训练好的模型,更多地了解机器学习框架下的神经网络(图1)。

图1. TensorFlow Playground提供了一个交互式的沙箱,用于探索TensorFlow的基础。 (来源:Google)

即使不深入研究机器学习算法的内部工作远离,开发人员也可以开始将这些技术应用于数据集。Google TensorFlow提供预先训练好的模型和示例,以及TensorFlow框架和针对如自然语言处理、音频识别和图像识别等应用流程。

对于更有经验的用户来说,使用机器学习会简单得多。由Facebook和微软推出的开放神经网络交换(ONNX)格式为在机器学习框架之间移动的模型提供了一个标准。除了这些公司对Caffee2和Cognitive Toolkit的早期支持之外,亚马逊最近还推出了一个开源的Python软件包,用于将ONNX模型导入Apache MXNet。

兴奋点:

数据不会短缺

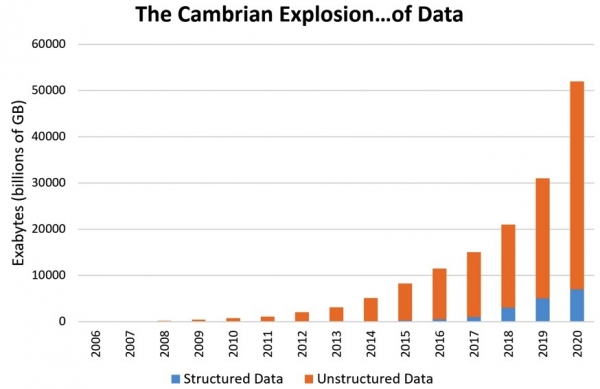

随着企业完成他们的数字化转型,物联网等(图2)重要项目催生了很多新的数据源,因此数据科学家不会缺少数据的。受这些和其他来源的驱动,与大数据相关的每个参数都将继续迅速演变:数据量自然会随着来源的增加而呈现上升趋势;随着企业提高数据分解以降低粒度,数据速度将会增加;随着物联网应用上线,以及企业合作伙伴共享关键数据源,数据的多样性将会随之迅速增加。

图2. 更多的数据来源意味着数据量、速度和多样化的激增。(来源:Patrick Cheesman)

然而,随着企业在生产中使用更深层次的分析和机器学习模型,数据科学家的工作将因为可以得到中立数据集而受益,用于测试和优化数据处理链、机器学习模型的广泛类别、甚至是算法本身。幸运的是,数据科学家可以随时访问各种公共数据集。例如,AWS提供了对环境、生命科学、图像等公共数据集的免费访问。同样,Google提供了各种各样的BigQuery公共数据集,其中包括GitHub代码、NOAA天气数据等等。数据科学家还可以通过data.gov访问超过20万个美国政府开放的数据源。

兴奋点:

大数据工具可以更有效地进入企业

从Hadoop和MapReduce早期开始,大数据分析工具已经发展成为一系列广泛的工具和平台。2018年,这种趋势将持续下去,人们越来越频繁地将数据提炼成更有用的信息,并利用一系列开放源代码和专有软件包来跟上数据快速增长的步伐。

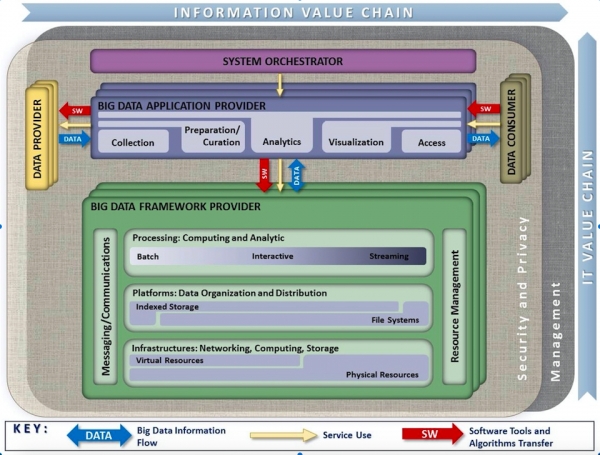

随着企业要应对更多的数据生产者和消费者,大数据需求甚至超越了功能强大的Hadoop分布式文件系统(HDFS)的功能。今天,企业面临着结构化和非结构化数据的混合,传统批处理、流分析和来自任意数量数据存储库的交互式查询等等这些复杂而混合的分析场景。大数据架构试图通过构建在(用于数据管理和计算的)高性能框架上的综合工具链来满足这些要求(图3)。

图3. NIST大数据参考架构,构建信息价值链的指南。(来源:NIST大数据公众工作组)

Apache Hadoop框架已经发展到包含大量解决大数据分析方面问题的工具,以及相关的Apache项目解决了更为复杂的需求。例如,Apache Spark补充了Hadoop以批处理为主导的MapReduce处理模型,提供了对数据流和交互式查询的实时分析。Apache Yarn提供了一个复杂的框架,其中包含资源管理器和作业调度程序,能够协调多个计算节点上的多个应用。因此,Apache Spark可以作为独立服务运行,也可以使用Yarn作为Hadoop集群上的Hadoop模块运行。

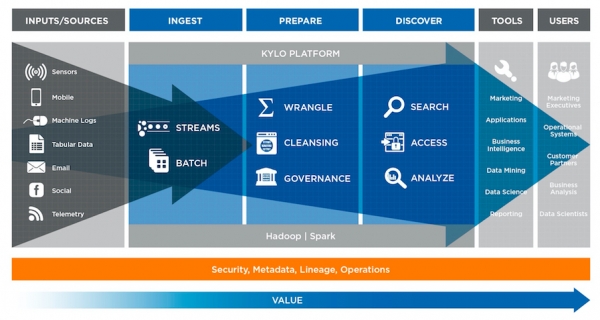

随着企业将不同来源的结构化数据和非结构化数据汇集到数据湖中,相同的做法被作为扩展大数据工具范围的基础。例如,Kylo开源平台建立在Apache框架之上,以解决相应更复杂的数据流和数据管理要求(图4)。

图4. Kylo旨在为数据湖提供开源平台。(来源:Teradata)

兴奋点:

基础设施上升到支持大数据的数量和速度

越来越多的数据、工具和支持平台,当然就意味着对合适的计算基础设施不断增长的需求,大数据工作者不会对2018年感到失望的。超大规模云服务提供商将继续扩大数据中心来满足这些需求,提供更多的集群和更快存储运行在更快的网络上。这也使更多的传统企业软件公司变成了硬件开发公司。例如,AWS使用自己的定制路由器,这些定制路由器使用基于Broadcom Tomahawk的专用ASIC来支持128个25 GbE通道。

在开放计算项目(OCP)的努力下,开源硬件在数据中心中不断获得推动力。 OCP在提高数据中心性能和效率方面的合作方式已经不仅仅是体现作为一个讨论用的公开论坛。参与者继续分享开放的规范。例如,微软在去年分享了Project Olympus服务器机架设计之后,向OCP社区提供了专注于平台安全的Project Cerebus规范。

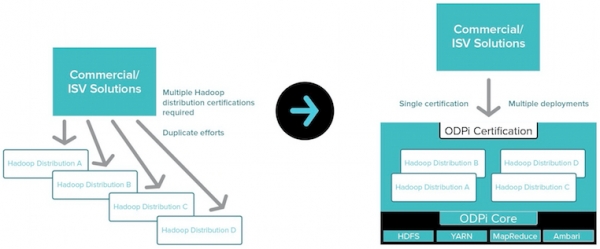

随着基础架构的速度和容量的不断攀升,企业经常发现自己仍然要面对各种不同的Hado哦派配置等问题。有一个工作组一直在致力于简化这其中的流程。在Linux基金会的主导下,ODPi试图消除对于不同平台的多个Hadoop发行版的需求(图5)。

图5. ODPi试图简化Hadoop发行版。(来源:ODPi)

担心:

必要的技能严重短缺

大数据工具可使深度分析更容易获得,但仍然需要数据科学的坚实基础。不幸的是,数据科学家将在2018年保持供不应求的状态,开放职位与合格个人之间的差距将继续增长,这可能是阻碍大数据成功最令人担忧的挑战之一。

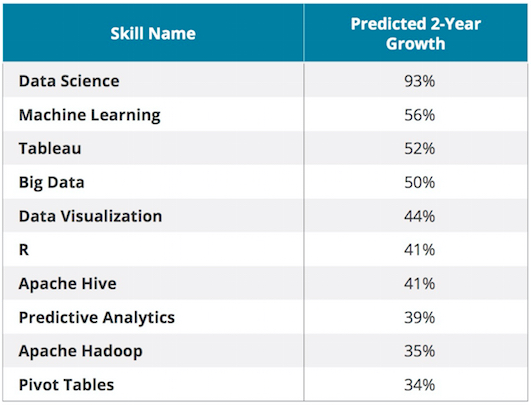

Burning Glass Technologies(BHEF)和IBM的一项研究显示,合格的数据科学家明显不足(图6)。更糟糕的是,现有数据科学家的数量增长可能远远没有达到大数据本身增长的预测水平。自动化技术将为传统数据科学任务(如数据清理和非结构化数据解耦)提供一些缓解措施,但是大数据的创新应用仍然与可用的大数据专家资源密切相关。

图6. 关键数据分析技能需求的增长速度远远超过所能供应的水平。(来源:IBM)

担心:

隐私问题变得可执行

欧盟一般数据保护条例(GDPR)自2018年5月25日起生效,适用于任何处理欧盟居民数据的企业组织。即使是在欧盟以外的公司也需要遵守GDPR,并且可能面临严重的违规处罚。对私人数据的严格管制和违规处罚,对于那些要在美国HIPAA安全规则下保护健康数据的公司来说并不陌生。即使非故意的违规行为也会导致罚款,故意忽视对健康数据的保护将要面临重大罚款和多年徒刑。此外,消费者日益关注的数据隐私重要性甚至超过了监管要求。

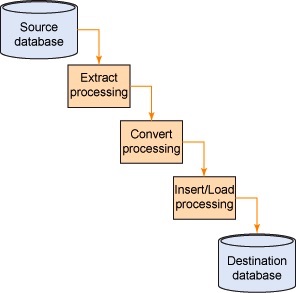

诸如金融行业这样的细分市场,多年来依靠数据脱敏(Data masking)技术来去除个人可识别的数据。利用这些技术,数据流过程中采取额外步骤,来提取敏感数据,将敏感数据转换为另一种字符串,并将这些数据混入数据集中以加载到目标数据库(图7),从而将其去个性化。数据脱敏技术可理想地确保数据集对于使用目标数据库的人类用户来说仍然有意义,因为诸如地址(例如151 W 34th St)的敏感数据被转换为一些安全但是有意义的字符串(诸如123 Hidden Street)。

图7. 传统的数据脱敏技术在数据流中插入额外的步骤。(来源:IBM)

GDPR要求企业使用类似的假名方法来隐去个人数据。如果没有数据科学家和隐私专家,公司将很难利用大数据工具来应用正确的方法组合。当个人担心他们的私人数据,并要求将这些私人数据从企业文件、数据库和数据池中删除的时候,这个问题就会变得更加复杂。特别是,如果个人资料保持不变,但数据转换和分析结果被埋没,这个问题就会变得几乎不可能。像Kantara Initiative的Consent Management Solutions Work Group这样的初期尝试,为处理这些问题提供了一个框架。

担心:

数据互操作性仍然有限

大数据概念(例如数据湖)旨在实现数据源的广泛混合。2018年,企业可能会因为通过合并多来源的数据而导致创造有用信息的能力受限而感到沮丧。

随着非结构化数据的增长,当企业在对比不同非结构化容器解析的数据时遇到了巨大的挑战,即使这些容器是来自于企业电子邮件流量这样相同的来源。在结构化数据中,语义问题常常由于模式和数据定义的性质而减少。

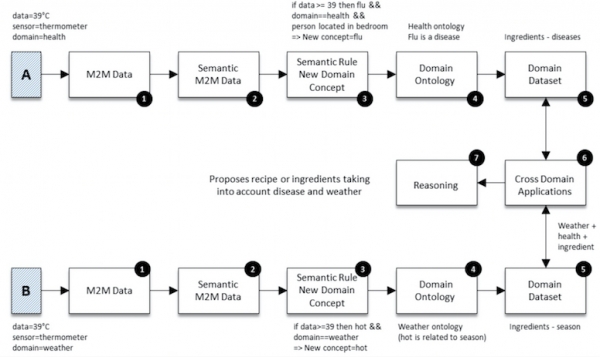

如果语义上等同的数据点与完全不同的上下文相关联(例如当用人体温度计和室外温度计测量温度时,温度的重要性),那么数据互操作性问题变得更为复杂。温度数据的上下文反映了明显不同的含义,需要一个统一的语义元数据框架来确定有用的结果组合(图8)。上下文敏感的解析和标记这一新机制,将有助于解决更现实的情况,但解决此问题的方法取决于是否有经验丰富的数据科学家,以及数据共享合作伙伴之间对数据语义和广义本体的一致性。

图8. 跨域应用(6)中有用的推理(7)需要一致的语义(2)和本体(4)。 (来源:Murdock,Paul等,物联网的语义互操作性)

担心:

安全缺陷威胁数据完整性

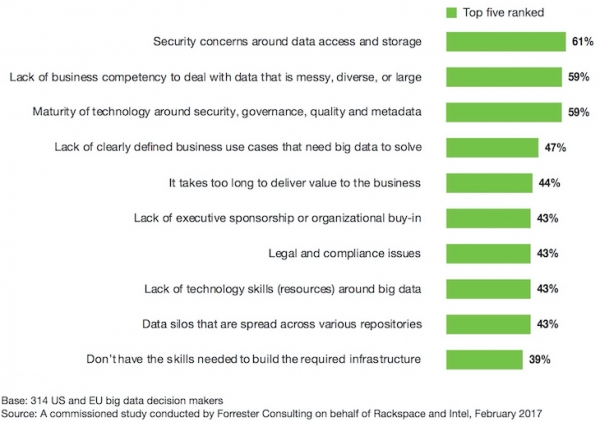

与几乎所有的在线资产一样,数据安全在2018年仍将是一个值得关注的问题。这仍然是整个业界最关注的问题之一,这一点也不意外。在Forrester针对314位高级公司经理、IT经理和高级数据分析领导者的调查中,受访者提到了与存储和数据完整性相关的数据安全问题(图9)。虽然有个别细分的安全方案是已经有了的,但要组合成实用的解决方案,还需要把技术和实践精心组合起来。

图9. Forrester调查发现,数据安全性仍然是企业管理人员最关心的问题。(来源:Rackspace)

在安全薄弱的环境中,对机器学习模型依赖的增加带来了额外的难度。犯罪分子通过向数据源中加入恶意数据流,入侵那些利用新数据趋势来进行训练的模型。最糟糕的是,网络犯罪分子可以使用微妙的“数据中毒”来将企业分析转向他们所选择的方向,从而在机器学习模型中创造出一种零日漏洞。不管怎样,数据中毒在单个的企业中是现实存在的威胁,如果企业之间共享数据的话可能性就更高了——例如汽车制造商将自己的物联网数据与交通基础设施合作伙伴共享的物联网数据结合起来。分布式账本技术被证明是维护这些数据集安全性的理想选择。在实践中,广泛分布的开放式分类账(例如区块链)固有的性能限制,可能会限制其在静态数据集、而不是动态数据流中的早期应用,尽管在基于更受限的分布式方法中,这种情况可能会有所改变。

来源:EETimes

好文章,需要你的鼓励

VSCO Capture新增视频拍摄功能迎接新年到来

VSCO今日更新VSCO Capture应用,新增视频拍摄功能。用户现可在拍摄照片和视频时应用并调整VSCO的50多种滤镜预设,包括经典胶片到现代创作风格。新版本还推出胶片颗粒滤镜,可动态控制纹理强度、大小和色彩。用户能将颗粒滤镜叠加到Film X滤镜上,结合柯达、富士和爱克发胶片风格,保存个性化胶片配方。

ETH苏黎世突破性WUSH技术:让AI大模型压缩实现接近零损失的革命性方案

瑞士ETH苏黎世联邦理工学院等机构联合开发的WUSH技术,首次从数学理论层面推导出AI大模型量化压缩的最优解。该技术能根据数据特征自适应调整压缩策略,相比传统方法减少60-70%的压缩损失,实现接近零损失的模型压缩,为大模型在普通设备上的高效部署开辟了新路径。

Instagram负责人:AI内容泛滥,为真实媒体加指纹比识别虚假内容更实用

Instagram负责人Adam Mosseri表示,AI生成内容已经占据社交媒体主导地位,预计将超越非AI内容。他认为识别AI内容的技术效果不佳,建议转而为真实媒体建立指纹识别系统,由相机制造商在拍摄时进行加密签名。Mosseri还指出,创作者应优先发布"不完美"的原始图像来证明真实性,因为精美方形图片的时代已经结束。

机器人终于能读懂你的手势了!弗吉尼亚大学团队让机器人变身“人类动作翻译官“

弗吉尼亚大学团队创建了Refer360数据集,这是首个大规模记录真实环境中人机多模态交互的数据库,涵盖室内外场景,包含1400万交互样本。同时开发的MuRes智能模块能让机器人像人类一样理解语言、手势和眼神的组合信息,显著提升了现有AI模型的理解准确度,为未来智能机器人的广泛应用奠定了重要基础。

VSCO Capture新增视频拍摄功能迎接新年到来

大学辍学成为初创企业创始人最抢手标签

微软如何满足客户需求:安排比尔·盖茨接见的巧妙方法

路创Aurora调光器完美解决飞利浦Hue智能灯泡最大痛点

Fizz CEO解析匿名社交如何俘获Z世代用户

教育科技创业者分享社群构建与用户留存策略

戴姆勒卡车运用图数据库技术梳理IT架构获运营红利

SwitchBot推出AI录音器AI MindClip,打造个人记忆第二大脑

Plaud推出新款AI可穿戴设备,有望取代Otter.ai

Instagram负责人:你的眼睛已经不能分辨什么是真实的了

派拓网络安全官:智能体将成2026年最大内部威胁

Subtle发布搭载降噪模型的无线耳机